ローカルのコンテナ上で、Next.jsのnext-auth使用してビルド後に実行したらエラーになった件

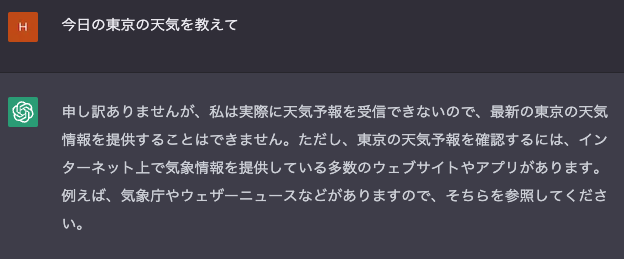

Nextjsで実装していたときに、

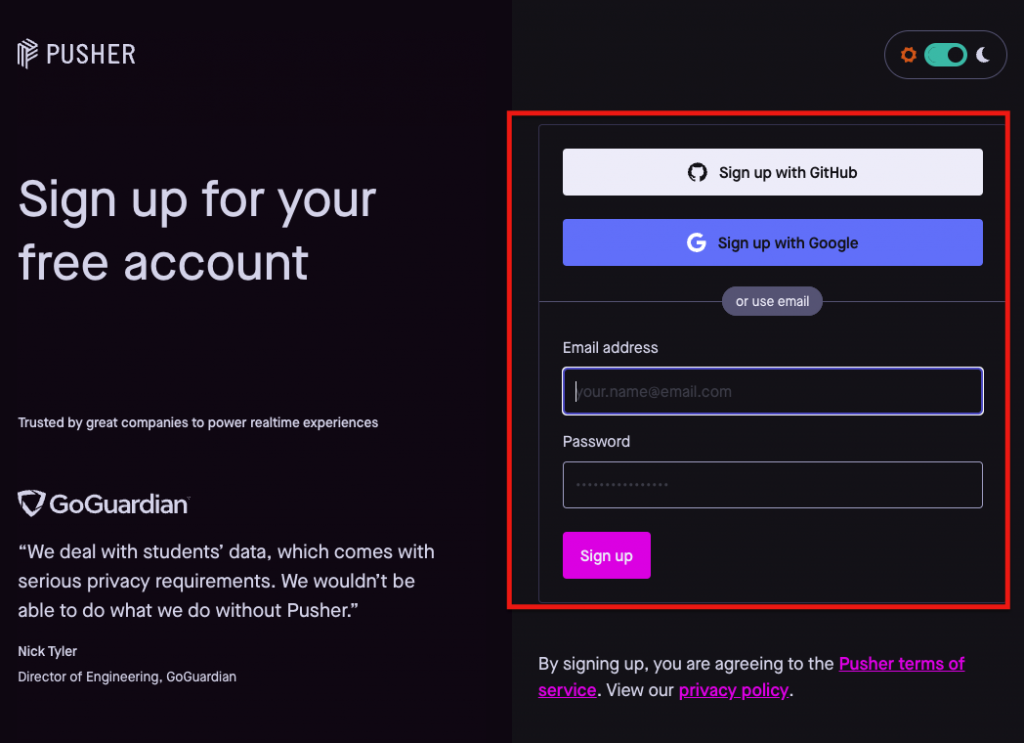

認証周りを構築しようとした時に、

何かライブラリなどを用いて、

GoogleのOAuthでの認証を試そうと考えました。

現時点で調べていると、

- 「Auth.js(NextAuth.js)」

というライブラリが良さそうなので、

こちらを試してみることにしました。

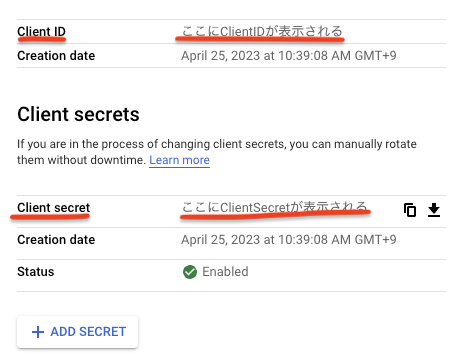

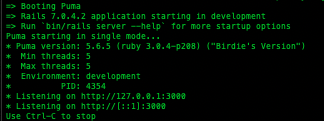

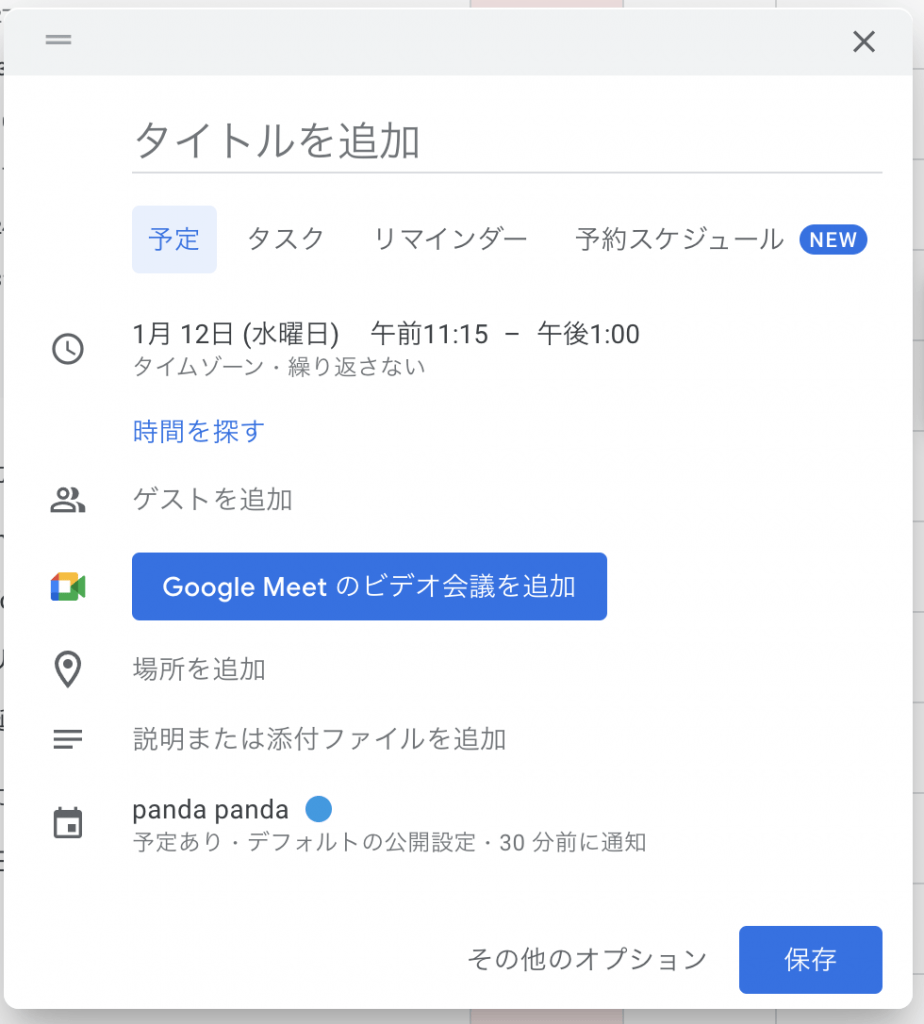

今回は、

ライブラリ「Auth.js(NextAuth.js)」を用いて、

Google OAuthの認証を試していたので、

その時にビルドまでうまくいったのだが、

実行するとエラーになった時のメモを

備忘録としてこの記事に残します。

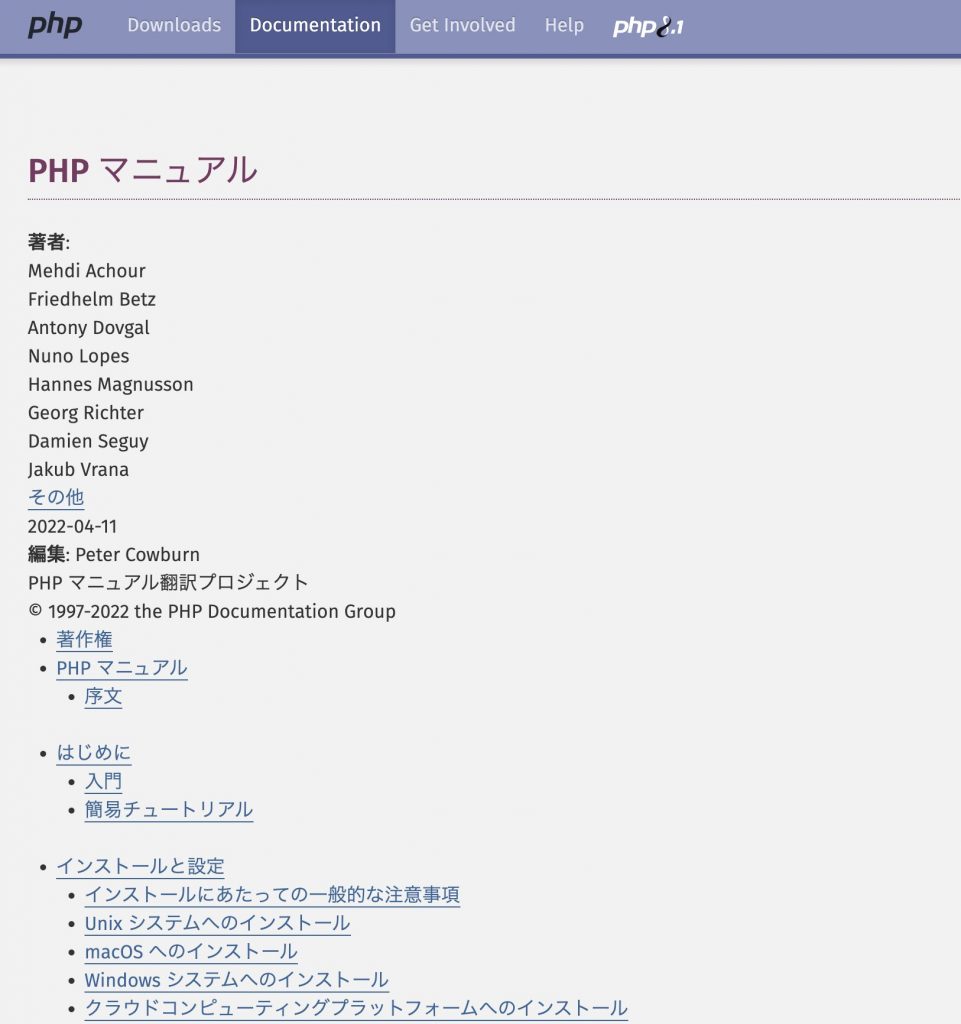

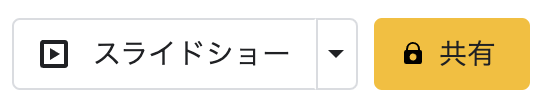

公式サイトの情報

公式サイト

まずは、公式サイトでNextAuth.jsのことを確認

自分が確認した時点(2023/04/25)で、

NextAuth.js is becoming Auth.js! 🎉

Read the announcement. Note,

this site is under active development.とアナウンスされているので、

それぞれのリンクをメモしておきます。

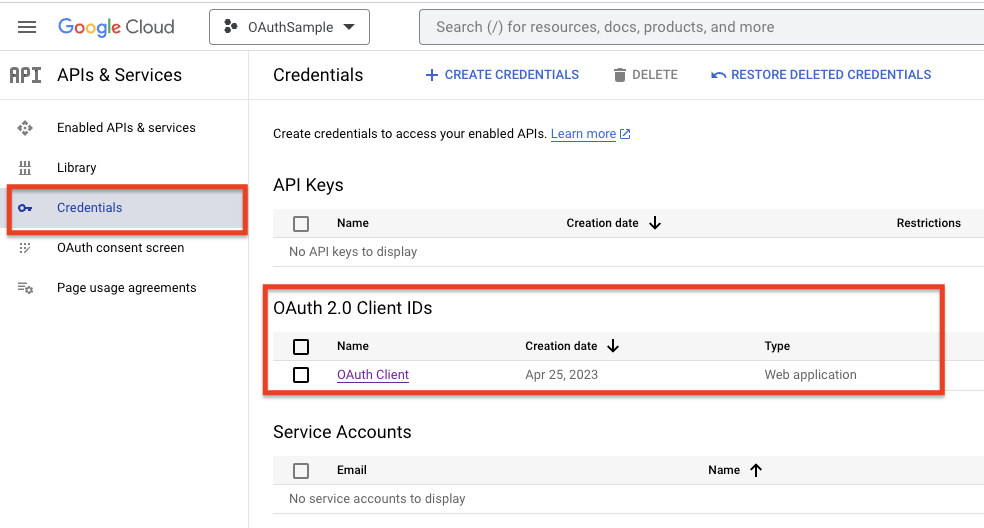

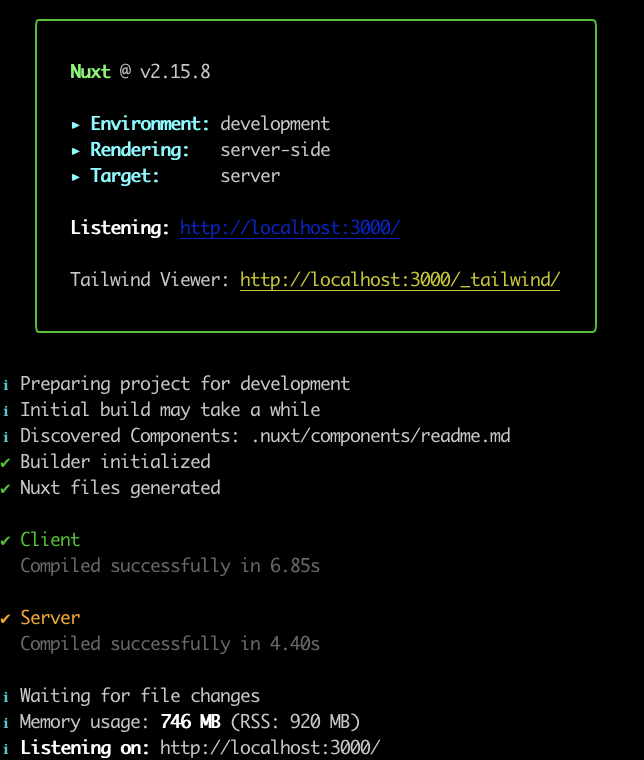

nuxt-authでGoogle認証を試した

今回のビルドエラーになったのは、

Next.jsでGoogle認証を試していたのだが、

開発モードではうまく挙動していた。

TypeScriptを使っているので、

ビルド時にエラーになったが、

ベースとなるやっていることは、

以下の記事を参考。

Next.js でGoogle OAuthをAuth.js(NextAuth.js)で試した件

ビルドのエラーは調整済み

ビルドについてもエラーになったが、

以下の対応をやって、

問題なくビルドは完了している。

Next.jsのnext-auth使用してビルドしたらエラーになった件

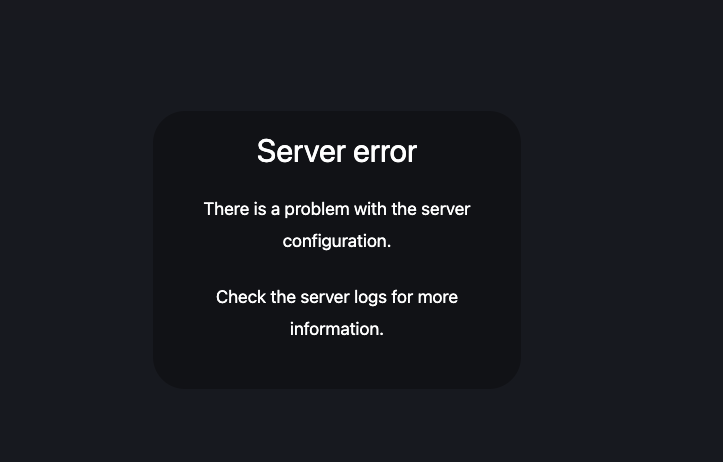

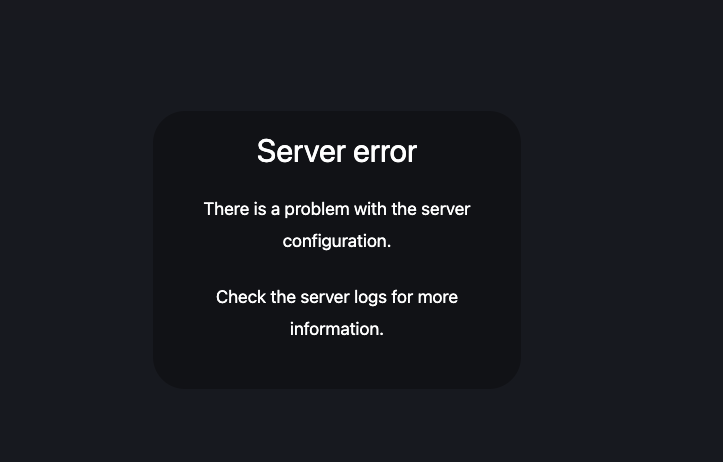

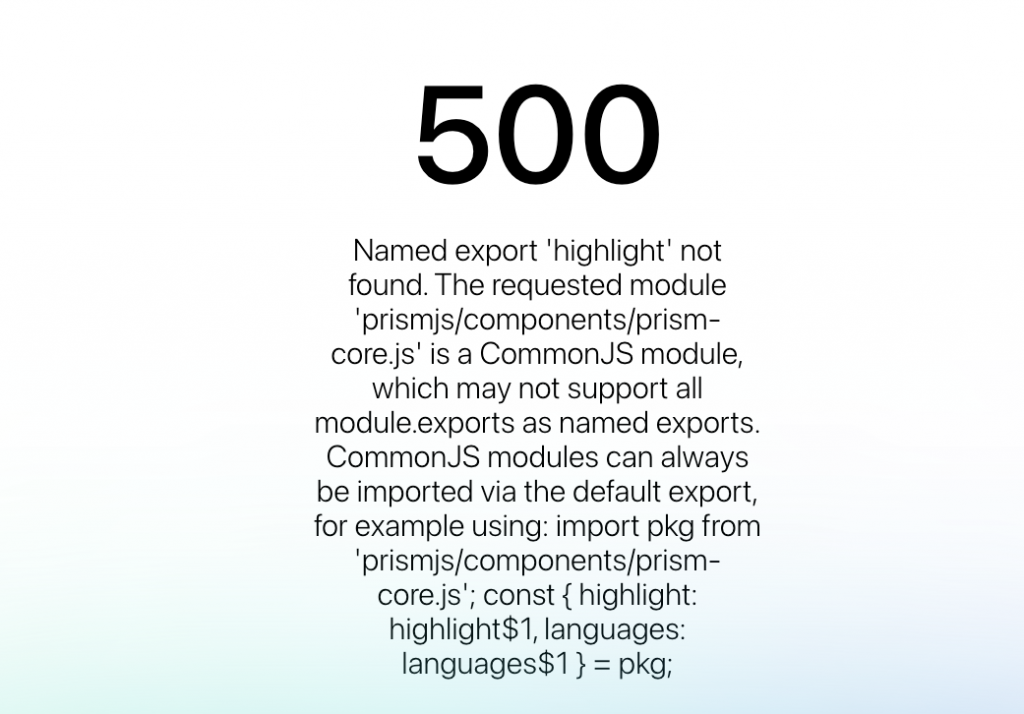

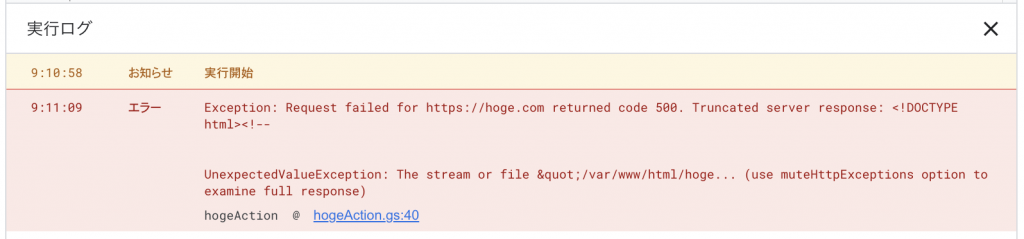

実行エラー

実行したら、

エラーが発生した。

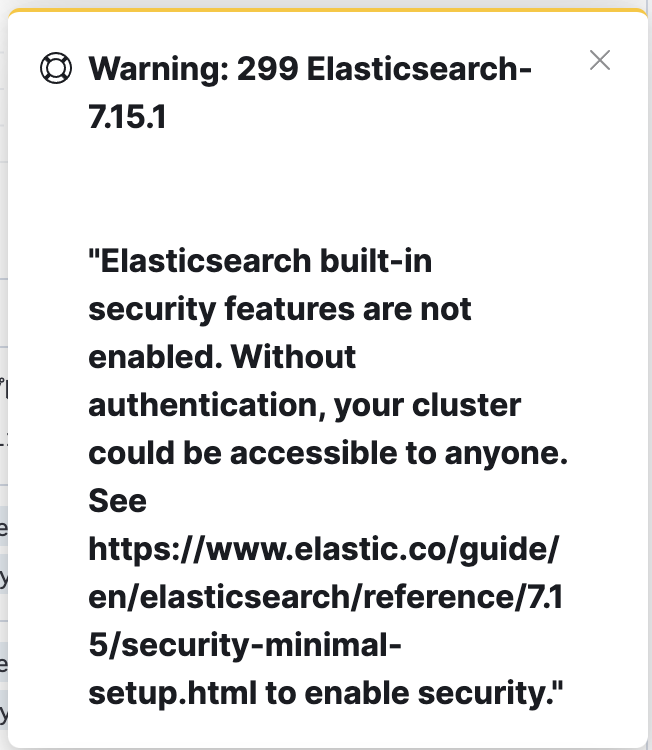

エラー内容

Error: Error serializing `.csrfToken` returned from `getServerSideProps` in “/auth/signin”.

Reason: `undefined` cannot be serialized as JSON. Please use `null` or omit this value原因

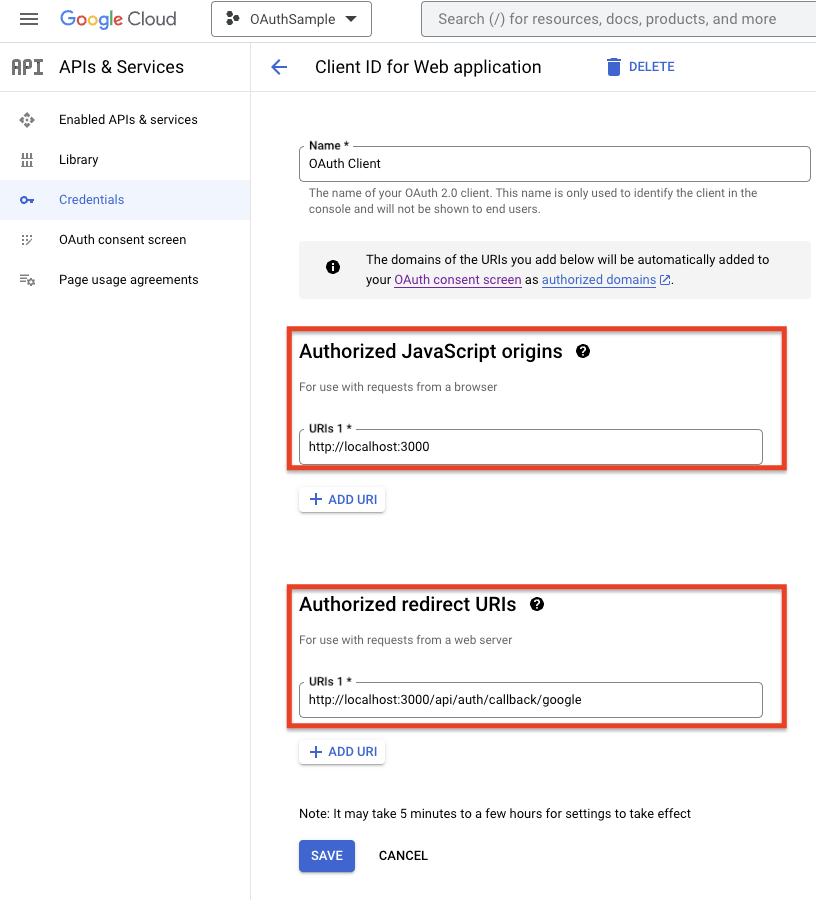

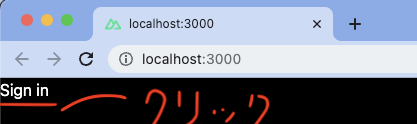

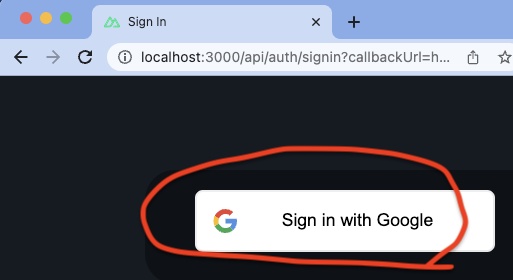

今回、ローカルで各種設定をした上で、

ブラウザで、

http://localhost:8032/api/auth/csrfhttp://localhost:8032/api/auth/providersなどを試したら、

うまく挙動していた。

ここまで確認したら、

実行しているローカル上で、

next-authでの動きは問題ないかと。

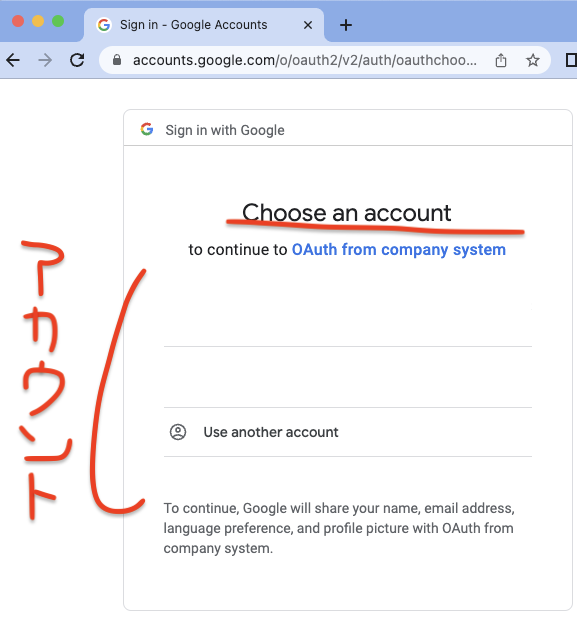

GCP自体の設定も問題ないので、

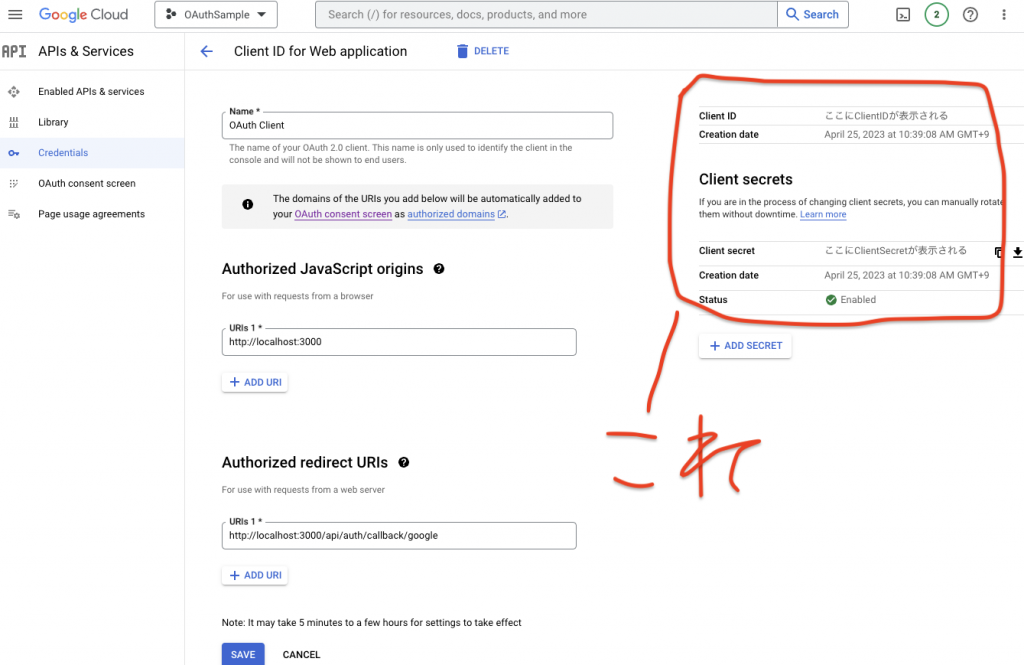

考えられることとしては、

サーバーサイドのみでの挙動が、

うまく処理されていないということ。

なので、その辺りを色々と試した結果、

9000/tcp, 0.0.0.0:8032->8092/tcpという感じで、

元々は、ポート番号を、

ローカルのホストの番号とコンテナのポートの番号が違う

ということなので、

ローカルのホストの番号とコンテナのポートの番号を合わせる

という対応をすると、

うまく挙動できました。

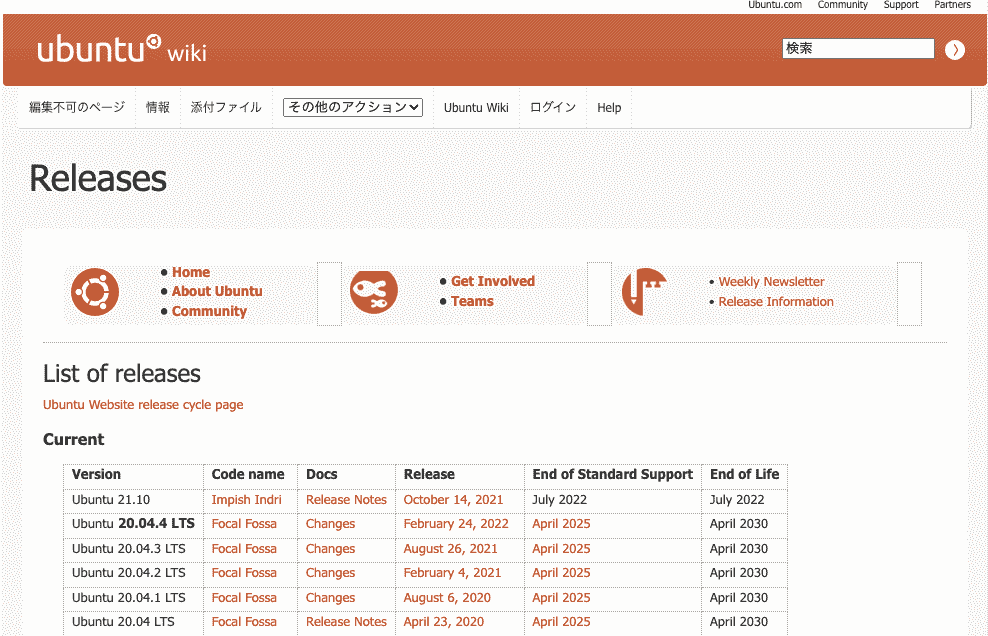

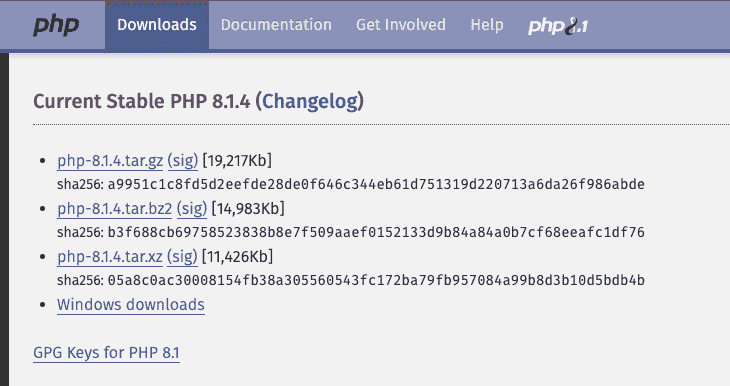

Ubuntuでphp-fpmの設定を変更したことで、502エラーでアプリケーションが動かなかった件

Ubuntuで、

Nginxとphp-fpmを使って、

Webサーバーを起動させることで、

アプリケーションを動かしていました。

しかし、

なぜか、php-fpmがステータスがfailedで、

うまく起動していません。

この件の対応した時のメモです。

php-fpmの状況確認

確認コマンド

sudo systemctl status php8.1-fpm.service確認結果

● php8.1-fpm.service - The PHP 8.1 FastCGI Process Manager

Loaded: loaded (/lib/systemd/system/php8.1-fpm.service; enabled; vendor preset: enabled)

Active: failed (Result: exit-code) since Fri 2024-09-06 10:48:15 JST; 24s ago

Docs: man:php-fpm8.1(8)

Process: 1100378 ExecStart=/usr/sbin/php-fpm8.1 --nodaemonize --fpm-config /etc/php/8.1/fpm/php-fpm.conf >

Process: 1100390 ExecStopPost=/usr/lib/php/php-fpm-socket-helper remove /run/php/php-fpm.sock /etc/php/8.>

Main PID: 1100378 (code=exited, status=78)

こちらでうまく起動できていないことが発覚。

php-fpmの設定不正確認

php-fpmの設定を変更したことが原因と考えられるので、

コマンドを使って不正設定を確認。

確認コマンド

sudo php-fpm8.1 -t確認結果

[06-Sep-2024 10:49:23] ALERT: [pool www] pm.start_servers(2) must not be less than pm.min_spare_servers(5) and not greater than pm.max_spare_servers(10)

[06-Sep-2024 10:49:23] ERROR: failed to post process the configuration

[06-Sep-2024 10:49:23] ERROR: FPM initialization failedphp-fpmの再起動

再起動コマンド

sudo systemctl start php8.1-fpmこちらで再起動もうまくいって、

問題なくアプリケーションも動くようになりました。

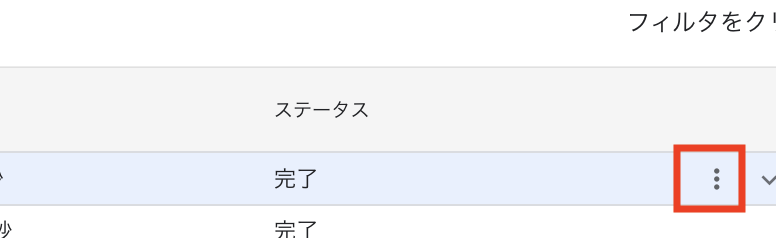

【GoogleAppsScript】claspでコード取得と反映する方法(Githubリポジトリのためのコード取得のために使用してみた)

Google Apps Scriptで、

各種処理を作っていく中で、

コードをGithubで管理したい

ということがあり、

公式で用意されているもので、

試してみた時のメモです。

clasp CLIをインストール

Node.js がインストールされていることを確認します。

その上で、

npm install -g @google/claspこのコマンドで、claspをインストール。

clasp で認証

ターミナル等のコマンドで、

clasp loginを実行して、

認証を実施してください。

claspを使用して、Google Apps Scriptのコードを取得

コマンドラインで、

clasp clone <スクリプトID>を実施することで、

コードを取得することができます。

スクリプトIDについては、

スクリプトエディタから

「ファイル」 > 「プロジェクトのプロパティ」

で確認することができます。

claspを使用して、Google Apps Scriptのコードを反映

取得したコードを、

各種エディタ等で更新した後、

clasp pushのコマンドを実行することで反映できます。

反映時のエラー

エラー内容として、

User has not enabled the Apps Script API.

Enable it by visiting https://script.google.com/home/usersettings then retry.

If you enabled this API recently,

wait a few minutes for the action to propagate to our systems and retryこのエラーが出ていましたが、

このエラーについては、

上記から設定ページにアクセスします

「Google Apps Script API」のトグルをオンにします。

トグルがオンになると、Google Apps Script APIが有効になります。

こちらを行ってから、再度、反映のコマンドを実行するとうまくいきました。

参考:Google Apps Scriptの一覧を確認

使用しているスクリプトを確認するには、

以下のリンクで確認できます。

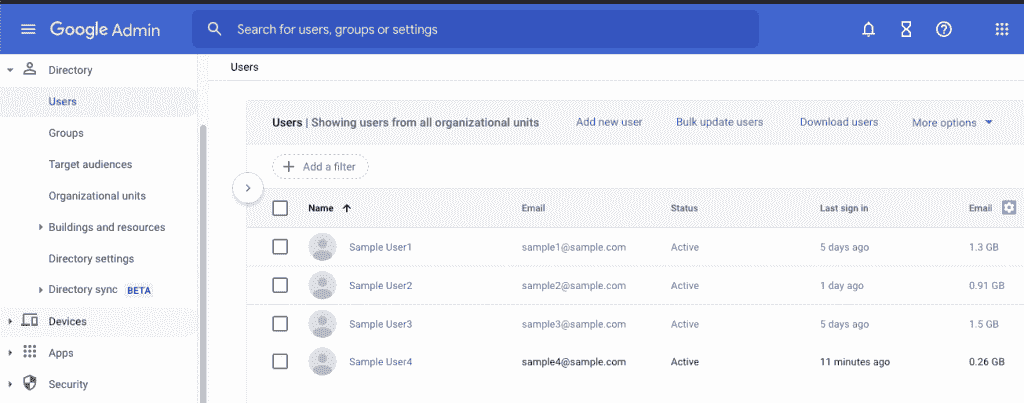

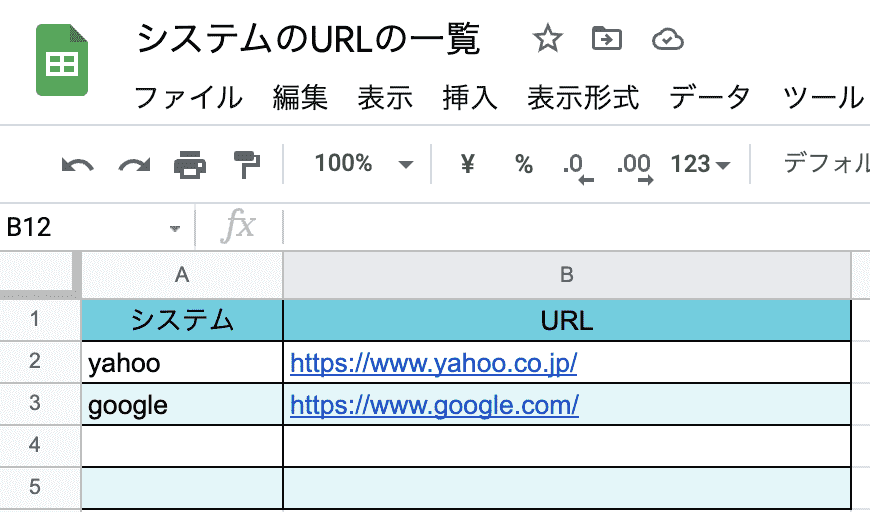

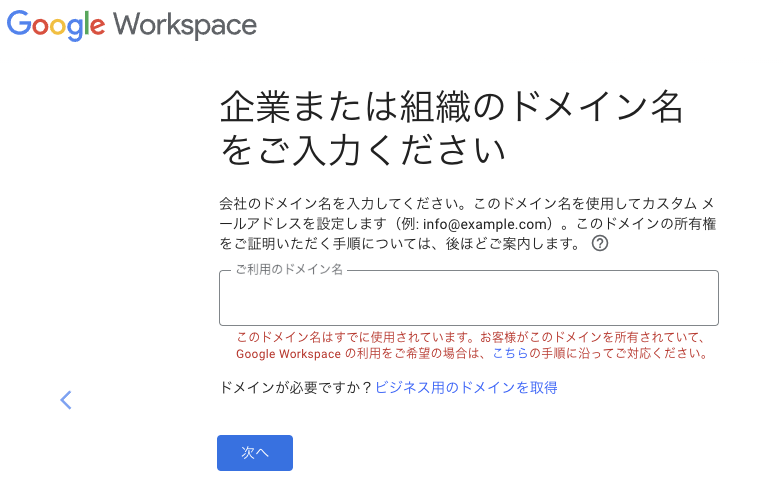

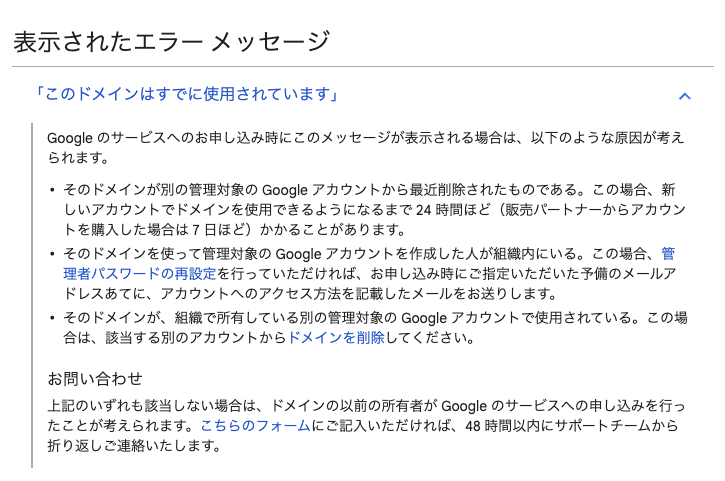

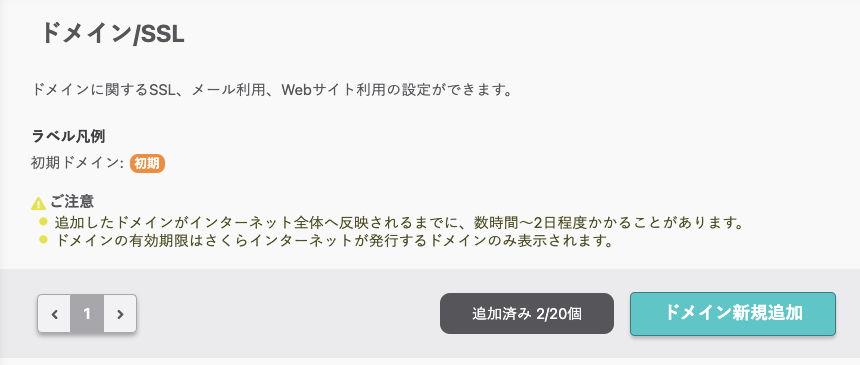

Google Workspaceでドメインを複数使い始めた件

管理ツールとして、

を使っていたけれど、

- 複数ドメインを使いたい

ということがあり、

Google Workspaceの設定をしていたので、

この記事に残しておきます。

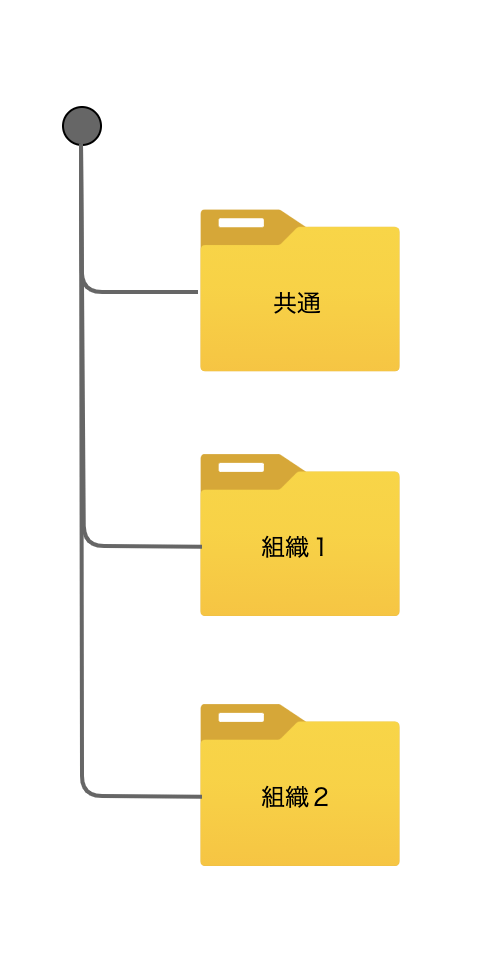

複数のドメインをGoogle Workspaceで使う方法の種類

複数のドメインをGoogle Workspaceで使う場合、

ドメインごとにGoogle Workspaceのアカウントを

作成する必要があるのかと思いましたが、

Google Workspaceのサポートの方に確認したところ、

私が確認した時点では、

- 別のGoogle Workspaceアカウントで分離する

- 同じGoogle Workspaceアカウントで複数紐付ける

ということでした。

上記のことを、

Google Workspaceの方での各種設定情報などの文言で言うと、

- 別々のプライマリドメインに分離して管理する

- プライマリドメインとセカンダリドメインで管理する

と言う違いのようです。

今回は、

- プライマリドメインとセカンダリドメインで管理する

こちらの同じアカウント内で、

複数のドメイン(プライマリとセカンダリ)で

Google Workspace上で管理する方法を試したメモです。

Google Workspaceの公式情報

問い合わせ担当者に今回、教えて頂いた情報は、

こちらのページに記載があります。

https://support.google.com/a/answer/7502379?hl=ja

上記のページを確認してもらいながら、

対応を進めてもらえると良いですが、

自分がやったことをメモ。

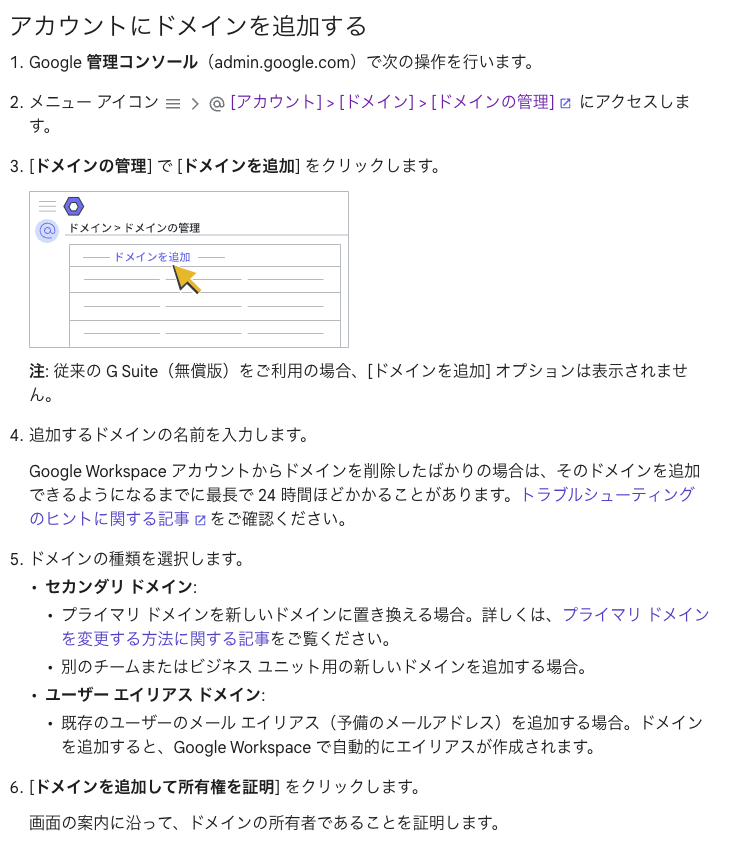

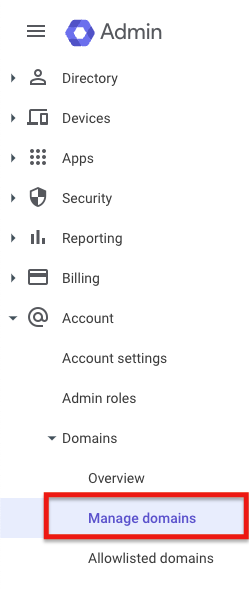

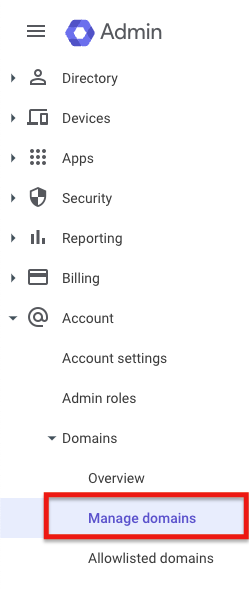

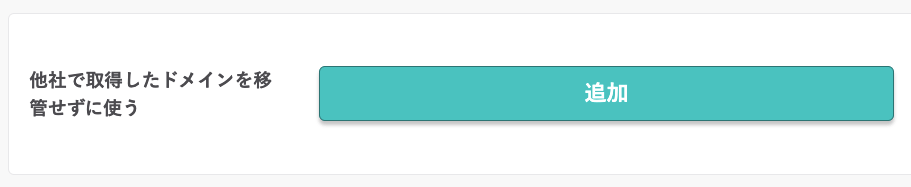

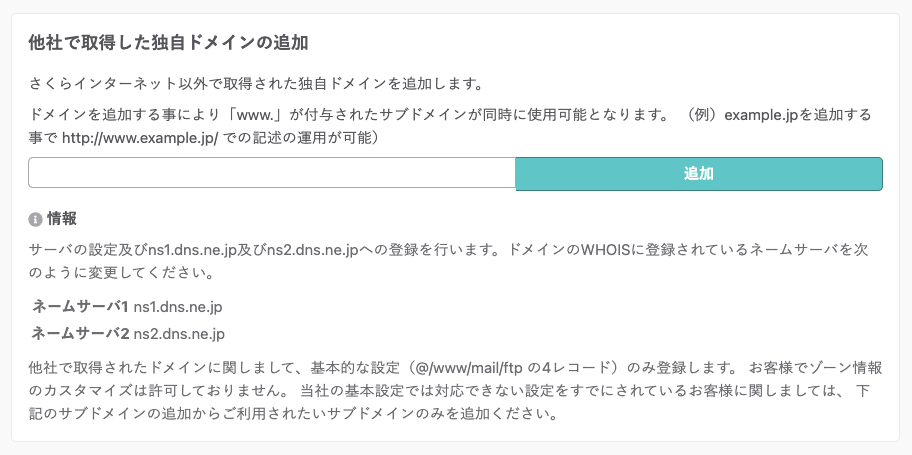

セカンダリドメインを追加

上記にも記載ある通り、

一部、引用しましたが、

ドメイン設定を確認して、

こちらの、

アカウント設定 – ドメイン – ドメイン管理

の設定から、

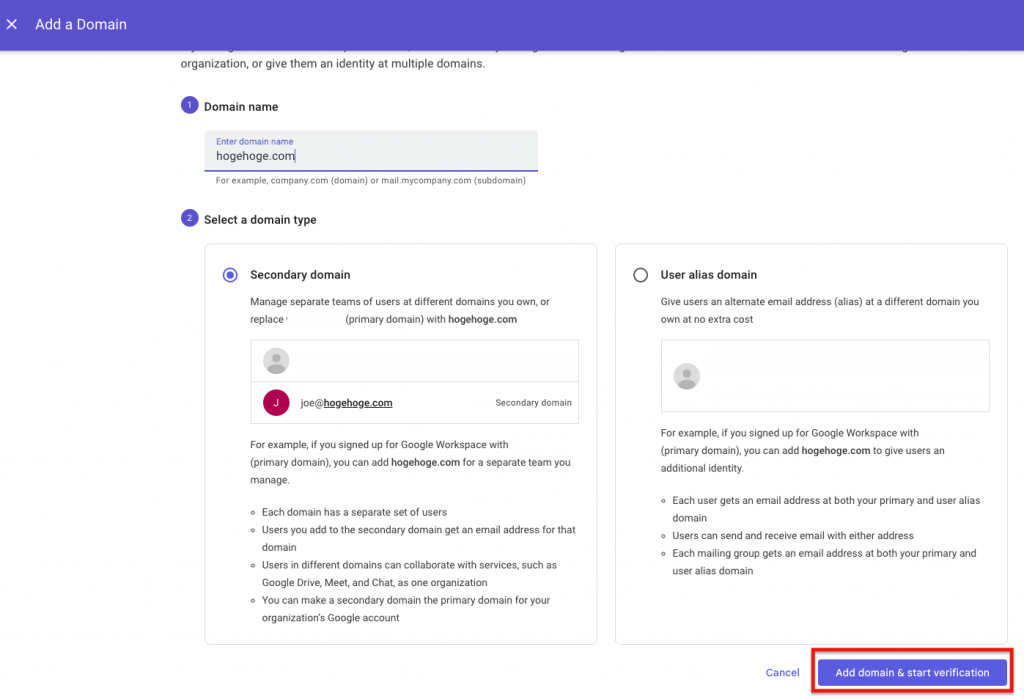

ドメイン追加を行うと、

次の画面が表示されます。

こちらの左側が、

セカンダリドメインの設定

という方法なので、

そちらを選択してから次に進んでください。

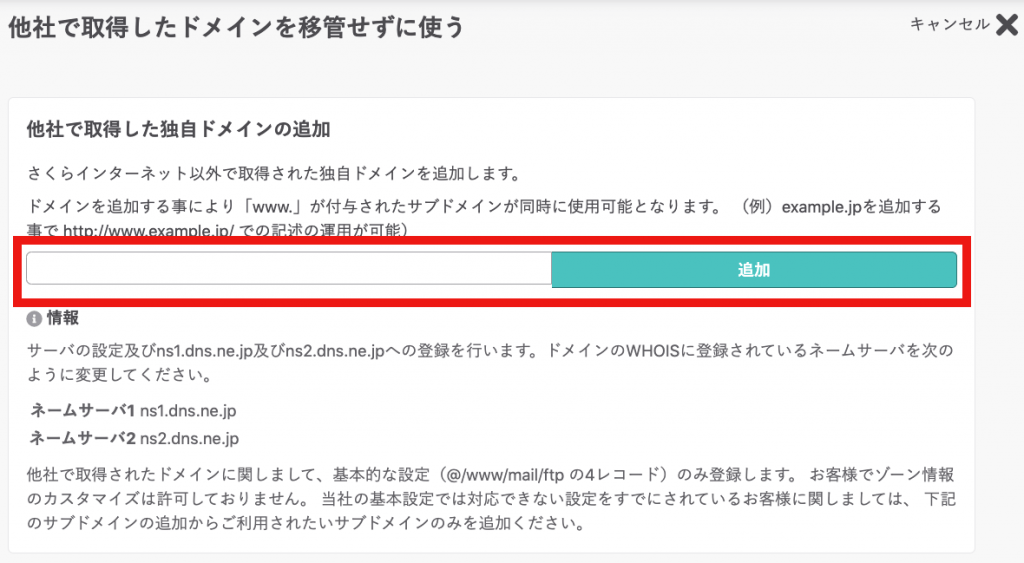

次の画面で進んだ時にTXTレコードの設定が必要となりますので、

その値を次のようにDNS設定に反映させる必要があります。

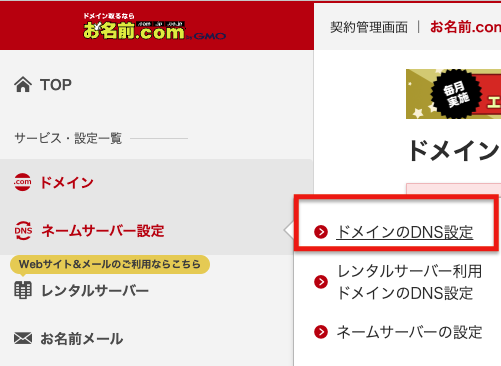

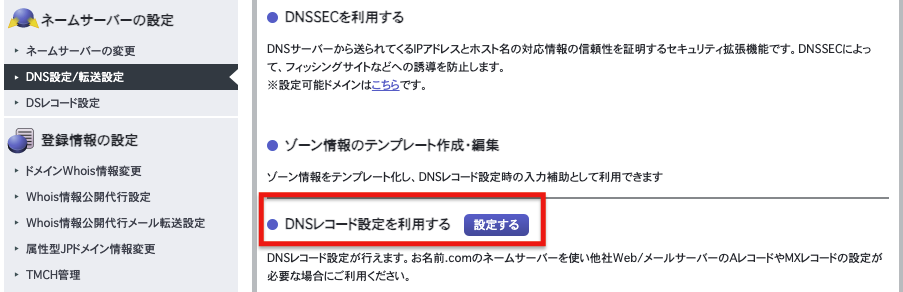

DNS設定にTXTレコードを設定(お名前.com)

上記のセカンダリドメインを追加すると、

TXTレコードをDNS設定に追加する

ということを行う必要があります。

必要なTXTレコードの値は、

上記のセカンダリドメインの追加を進めると表示されるので、

そちらの値を使ってください。

その値を、お名前.comで、

このドメインのDNS設定を進めます。

このDNSレコード設定から、

TXTレコードを追加します。

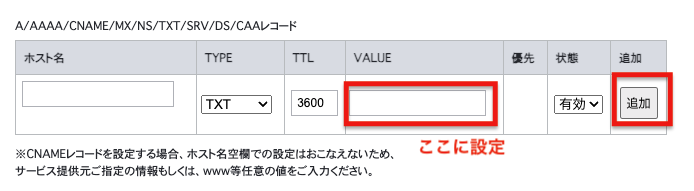

先ほどのGoogle Workspaceのセカンダリドメインの設定から、

設定するとなっているTXTレコードの値を、

お名前.comでは、

上記の設定で、

- TYPEを「TXT」に設定

- VALUEにGoogle Workspaceで表示された値を設定

という設定で、

追加ボタンで進めます。

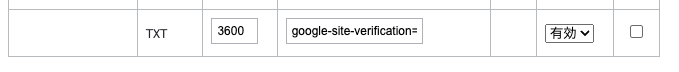

上記の追加で、

このように

設定されているとオッケーです。

これを確認できたら、実際の反映まで進めて下さい

状況によってこのTXTレコード反映までちょっと時間かかることもあるようです。

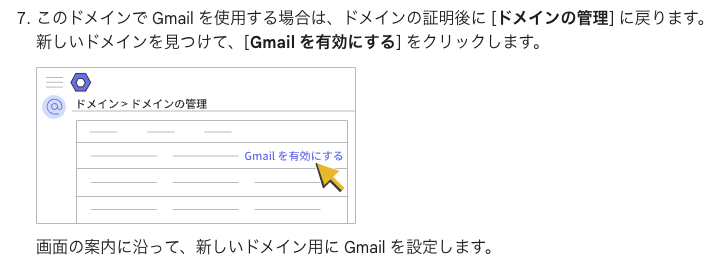

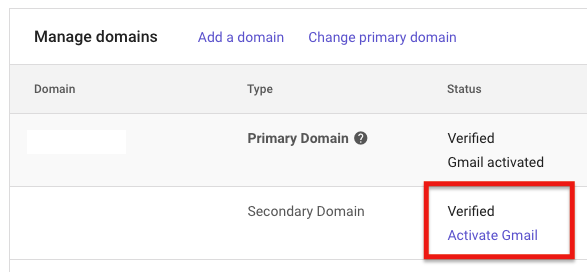

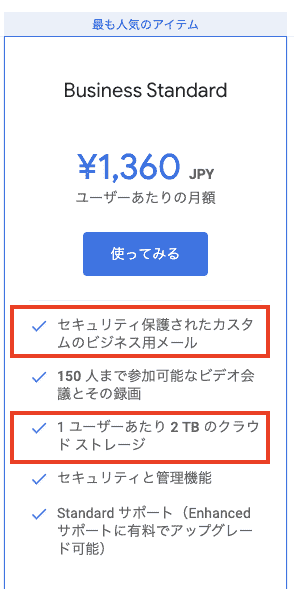

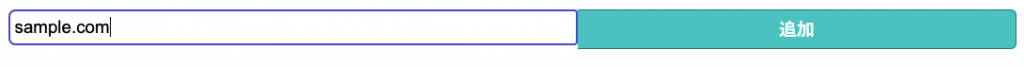

Google WorkspaceでGmailを有効にする設定

上記でTXTレコードの設定をした上で、

Google Workspaceでアカウントの追加まではできます。

アカウント作成して、

ライセンスを紐づけることで、

Gmailの送信までは動いたのですが、

受信がうまく動きませんでした。

そこで手順を再確認したところ、

1つ、漏れていました。

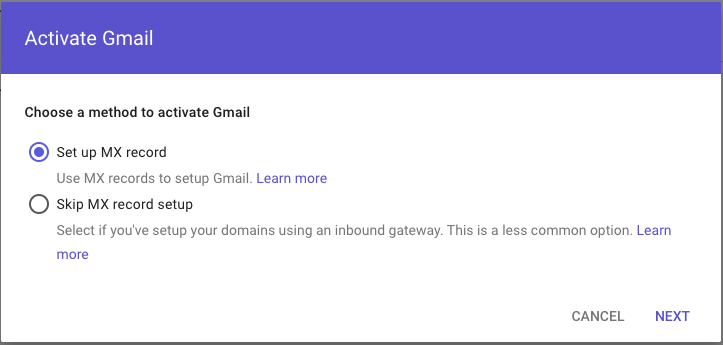

Google Workspaceで「Gmailを有効にする」設定が必要

という点でした。

設定手順の方にも記載ありました。

こちらが必要ですね。

実際にGoogle Workspaceで確認してみます。

こちらの画面で、

こちらで、

MXレコードの設定を進めます。

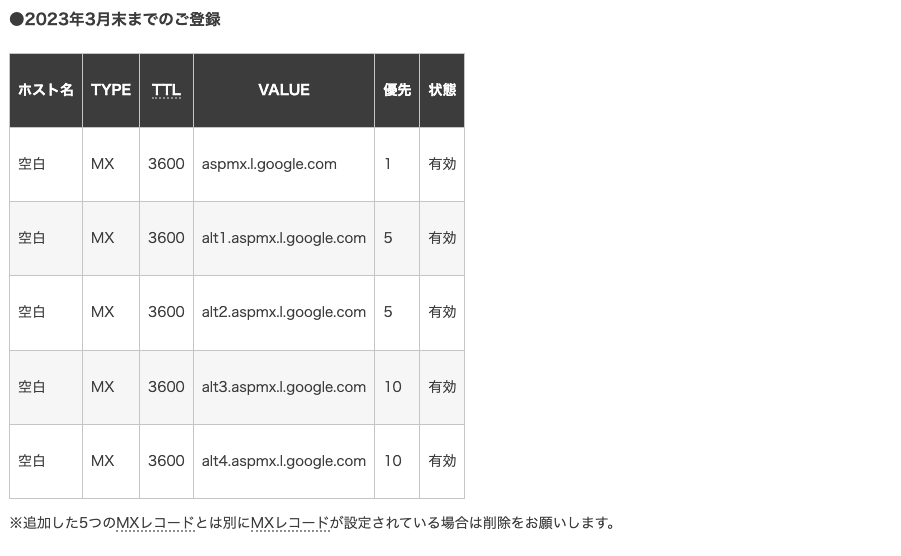

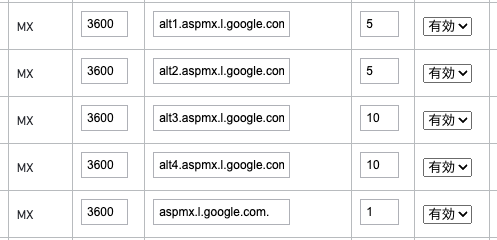

DNS設定にMXレコードを設定(お名前.com)

Google Workspaceのお名前.comに対して、

MXレコードを設定する方法は、

こちらに公式にも記載があります。

https://help.onamae.com/answer/20389

上記にも記載がありますが、

一部、引用しながら大切なポイントを共有しておくと、

なお、Google Workspaceのご登録時期により、設定いただくレコードが異なりますので、

下記より、該当時期のレコードをご確認ください。

という部分が重要で、

Google Workspaceのご登録時期により、設定いただくレコードが異なります

で設定が違います。

- 2023年3月末までのご登録

- 2023年4月以降のご登録

の2つで設定が違うので、

その点は、

記載内容を確認して進めます。

自分が確認した時点では、

この2つのどちらか、

自分が使っているGoogle Workspaceの登録時期を確認して、

上記のいずれかでお名前.comのDNS設定にMXレコードを追加します。

自分の環境では、

「2023年3月末までのご登録」に該当するので、

お名前.comのDNS設定でのMXレコードの設定は、

このように設定しました。

こちらで設定を反映すると、

Google Workspaceでのセカンダリドメインで、

プライマリドメインと含めて、

複数ドメインの管理とアカウントの作成、Gmailの送受信までうまくいきました。

参考:Google Workspaceの導入・活用の始め方

Google Workspaceの導入方法や、

実際の活用の始め方については、

以下のサイトを参考にしてもらえればと思います。

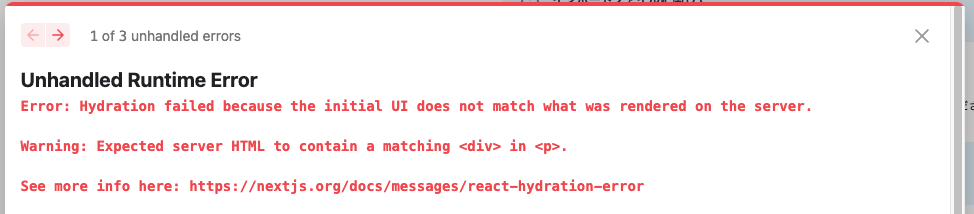

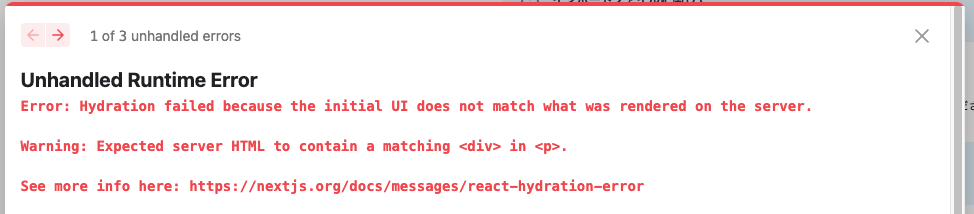

Next.jsで「Hydration failed because the initial UI does not match what was rendered on the server」のエラー発生

Nextjsで実装していたときに、

レイアウト周りのコードを調整していたのだが、

上記の画像のようなエラーが発生した。

タグの閉じ忘れなどかなと考えたが、

Next.jsのコーディング方針としておかしい書き方をしていたので、

それが原因で上記エラーが起こっているようだった。

今後のために

個人的な備忘録としてこの記事に残します。

エラー内容

エラーに関しては、

このようなエラー表示になっていた。

上記のエラー文言を確認すると、

以下のように表示されていた。

Unhandled Runtime Error

Error: Hydration failed because the initial UI does not match what was rendered on the server.

Warning: Expected server HTML to contain a matching <div> in <p>.

See more info here: https://nextjs.org/docs/messages/react-hydration-error参考

https://nextjs.org/docs/messages/react-hydration-error

エラー箇所

自分のコードの中で、

上記エラーが起きる箇所を、

地道に絞って行った時、

以下の部分が対象だった。

エラー発生部分

<Typography>

<div>文言</div>

<div>文言</div>

</Typography>上記がNext.jsのコーディングとしてよくなく、

それが原因だろうということで、

ChatGPTにも聞いてみたら、

指定されたコードに関するエラーの原因は、

<Typography> コンポーネント内で <div> を直接使用していることにあります。

<Typography> コンポーネントは、

Material-UI(現在はMUIとして知られています)の一部で、

テキストを表示するために最適化されています。

しかし、このコンポーネントはデフォルトで <p> タグを生成するため、

その内部で <div> タグを使用するとHTMLの構造的な問題が生じ、

Reactのhydrationエラーの原因となります。という感じで、

やはりコーディングが良くない。

上記の部分を調整して、

再表示したらエラー表示がなくなりました。

Gitを理解するために初心者におすすめのサイト・書籍

コードを管理するにあたって、

バックエンド、フロントエンドの両方で、

作成したコードに関しては、

「Git」(ギット)

を使って管理することが一般的になりました。

そんな中で、

実際にGitを使ってみたいけれど、

- 「Git」というのを初めて聞いた

- 「Git」を触り始めたけれど、よくわからない

という初心者に向けて、

おすすめのサイトと書籍を記載しておきます。

私自身も理解するために参考にしたサイト書籍なので、

同じように初めてGitに触れる方にも、

ぜひ参考にしてほしいと思います。

Gitを理解するために初心者におすすめのサイト・書籍

サル先生のGit入門

まずはじめにお勧めするのが、

サル先生のGit入門

というサイトです。

基礎的なところから、

- 入門編

- 発展編

- プルリクエスト編

- 逆引きGit

という流れで、

内容がしっかりとして、

基礎学習にはすごく良いサイトなので、

内容を理解していきながら、理解を深めていきたいという方にオススメです。

はじめてでもできる GitとGithubの教科書

次に紹介するのは、

はじめに読む書籍としてオススメな、

こちらの本です。

「Gitってなに?」

というところから始めるので、

- Gitって何?

- コマンドラインツールって何?

というところで引っかかる人は、

この書籍ではじめの一歩を踏み出すのがオススメです。

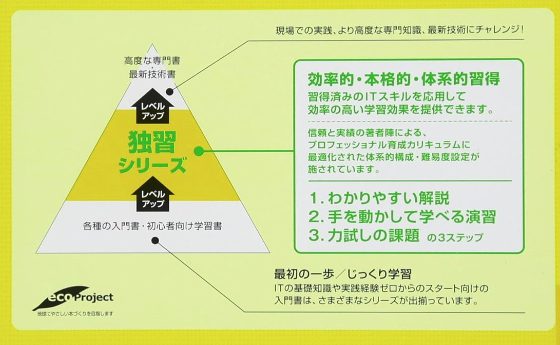

独習Git

エンジニア向けの書籍として「独習〜」というシリーズがあり、

その中の「Git」にフォーカスした独習シリーズの書籍です。

独習シリーズは、

上記(書籍の一部のキャプチャを引用)のように、

基礎向けの書籍を読んだ後に、

ステップアップとして使うのにオススメです。

もう少し、Gitを深く理解していきたいと考える初心者に、

オススメなので、使ってみてください。

docker-composeのbuildが「bookworm InRelease」などのコンテナを立ち上げて、コンテナにアクセスするための流れをメモ

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

docker-compose

を使っているのですが、

=> ERROR [ 3/22] RUN apt-get update

[+] Building 2.7s (9/26)

=> [internal] load build definition from Dockerfile

:

=> ERROR [ 5/22] RUN apt-get update

------

> [ 5/22] RUN apt-get update

#0 0.313 Get:1 http://deb.debian.org/debian bookworm InRelease [151 kB]

#0 0.362 Get:2 http://deb.debian.org/debian bookworm-updates InRelease [55.4 kB]

#0 0.383 Get:3 http://deb.debian.org/debian-security bookworm-security InRelease [48.0 kB]

#0 0.407 Err:1 http://deb.debian.org/debian bookworm InRelease

#0 0.407 At least one invalid signature was encountered.

#0 0.447 Err:2 http://deb.debian.org/debian bookworm-updates InRelease

#0 0.447 At least one invalid signature was encountered.

#0 0.488 Err:3 http://deb.debian.org/debian-security bookworm-security InRelease

#0 0.488 At least one invalid signature was encountered.

#0 0.494 Reading package lists...

#0 0.504 W: GPG error: http://deb.debian.org/debian bookworm InRelease: At least one invalid signature was encountered.

#0 0.504 E: The repository 'http://deb.debian.org/debian bookworm InRelease' is not signed.

#0 0.504 W: GPG error: http://deb.debian.org/debian bookworm-updates InRelease: At least one invalid signature was encountered.

#0 0.504 E: The repository 'http://deb.debian.org/debian bookworm-updates InRelease' is not signed.

#0 0.504 W: GPG error: http://deb.debian.org/debian-security bookworm-security InRelease: At least one invalid signature was encountered.

#0 0.504 E: The repository 'http://deb.debian.org/debian-security bookworm-security InRelease' is not signed.このようなエラーが発生。

今回の対応的には、

Dockerイメージやコンテナのキャッシュをクリア

という対応を行ったので、

自分の備忘録として、

忘れないうちにメモを残しておきます。

エラー内容

実行処理としては、

docker-compose -f docker-compose.sample.yml buildという形で、

docker-compose.sample.ymlというファイルを準備して、

そちらをビルドする流れてで進めていました。

このビルドを実行したところ、

=> ERROR [ 3/22] RUN apt-get update

[+] Building 2.7s (9/26)

=> [internal] load build definition from Dockerfile

:

=> ERROR [ 5/22] RUN apt-get update

------

> [ 5/22] RUN apt-get update

#0 0.313 Get:1 http://deb.debian.org/debian bookworm InRelease [151 kB]

#0 0.362 Get:2 http://deb.debian.org/debian bookworm-updates InRelease [55.4 kB]

#0 0.383 Get:3 http://deb.debian.org/debian-security bookworm-security InRelease [48.0 kB]

#0 0.407 Err:1 http://deb.debian.org/debian bookworm InRelease

#0 0.407 At least one invalid signature was encountered.

#0 0.447 Err:2 http://deb.debian.org/debian bookworm-updates InRelease

#0 0.447 At least one invalid signature was encountered.

#0 0.488 Err:3 http://deb.debian.org/debian-security bookworm-security InRelease

#0 0.488 At least one invalid signature was encountered.

#0 0.494 Reading package lists...

#0 0.504 W: GPG error: http://deb.debian.org/debian bookworm InRelease: At least one invalid signature was encountered.

#0 0.504 E: The repository 'http://deb.debian.org/debian bookworm InRelease' is not signed.

#0 0.504 W: GPG error: http://deb.debian.org/debian bookworm-updates InRelease: At least one invalid signature was encountered.

#0 0.504 E: The repository 'http://deb.debian.org/debian bookworm-updates InRelease' is not signed.

#0 0.504 W: GPG error: http://deb.debian.org/debian-security bookworm-security InRelease: At least one invalid signature was encountered.

#0 0.504 E: The repository 'http://deb.debian.org/debian-security bookworm-security InRelease' is not signed.このエラーが発生しました。

考えられる原因

考えられる原因としては、

- Dockerビルド時のリソース不足

- ネットワークの問題

- Dockerのバージョンに関する問題

- Dockerのイメージやコンテナ・キャッシュによる問題

が考えられます。

最終的には、

Dockerのイメージやコンテナ・キャッシュによる問題

が原因でした。

Dockerビルド時のリソース不足

デフォルトで割り当てられたCPUやメモリについて、

複数立ち上げを行っていると、

PCのスペック的には、

ビルドのプロセスでリソース不足が発生します。

ただ、今回の自分の環境では、

特に問題はなさそうでした。

ネットワークの問題

この点に関しては、

特に他のDebian系の環境で

apt-get updateを動かしてみても、

特に問題ない状態ですし、

自分のPCからの外部アクセスについても、

特に問題見当たらなかったため、

この点は影響なしと考えました。

Dockerのバージョンに関する問題

Dockerのバージョンについては、

バージョンごとに、

うまくいかない点が出てきますが、

自分は比較的バージョンを上げて対応しており、

同じビルドしている設定とは、

特にバージョンを変えていないので、

この点も問題なしと判断しました。

Dockerのイメージやコンテナ・キャッシュによる問題

上記に記載した点は問題なかったので、

最後の考えられることとして、

現在の自分の環境にあるDockerイメージや、

使っている・使っていたコンテナ・キャッシュ周りが影響して、

うまくビルドが動いていないことが考えられます。

キャッシュされたイメージやコンテナが原因で、

問題が発生していることもあるようなので、

まずは、(これは解決策ではありません)

docker-compose -f docker-compose.sample.yml build --no-cacheこちらで、

ビルドしているキャッシュ自体を使わないで、

ビルドプロセスを試してみます。

しかし、同じようなエラーとなります。

ビルドプロセスで使用されるベースイメージが更新された場合など、

キャッシュされた状態が原因でビルドが失敗することがあるようなので、

Dockerイメージやコンテナのキャッシュをクリア

を行います。

コマンド

docker system prune -aこちらを実行すると、

今までのイメージやキャッシュがクリアされます。

こちらでクリアしたのちに、

再度、ビルドプロセスを試します。

docker-compose -f docker-compose.sample.yml buildこちらを実行したら、

うまくビルドが完了しました。

これで解決ですね。

プログラミングの独学におすすめのサイト・サービス一覧

初心者の方が、

プログラミング学習を独学で進めていくと、

なかなか、プログラミング学習がうまく進まない…

どうしたらいいかな。

独学のためのサイトやサービスはないかな…

という感じで、

独学をする中でも、

書籍での学習挫折しそうになって、

せっかく始めたプログラミング学習をやめてしまうことがあります。

プログラミング学習の中では、

色々なことで、うまくいかないことはありますが、

- プログラミング学習を諦めずに、もう少し学習を続けてみること

- 学習内容としてインプットだけでなく、アウトプットもできること

- 学習の進捗や今後の流れなどがある程度、把握できること

という点のどれか、

または、複数満たせることが大切だと考えています。

そんな中で、

独学の時に書籍についても、

全体像把握という点ではおすすめな点はありますが、

1つの独学の方法として、

独学におすすめなサイトやサービスを活用してみる

ということが1つの選択肢になります。

そんな独学のサイトやサービスについてですが、

初心者の方には、

独学での学習をしていく中で、

自分の現時点での学習状況・理解度を把握することが大切

ということがあります。

その点を自分なりに考えた上で、

自分なりにあったサイト・サービスを見つけて活用すると良いでしょう。

また、人それぞれ、おすすめなサイト・サービスであっても、

使う中での好料の相談ができるところが多いので、

いくつかサイトやサービスはありますが、

一度、いくつか試してみて自分のに合っているのかを試してみることが大切です。

「使いやすい」とか「やっていて楽しい」など、

ちょっとしたことでも構いません。

自分なりに取り組みやすいサイト・サービスを活用しましょう。

とお伝えしています。

この記事では、

個人的にピックアップしたおすすめのサイト・サービスを載せています。

私なりのサイト・サービスに対する主観になりますので、

気になったものは、一度、自分なりに試してみてみることをお勧めします。

随時、初心者向けにオススメできるサイト・サービスを見つけたら、

追加していっているので、少しでも参考になれば嬉しいです。

プログラミングの独学におすすめのサイト・サービス一覧

[wpdatatable id=3]

Progate

初心者に特におすすめで、

スライド形式で分かりやすく、

RPGゲームのようなレベルを積み上げるサービス

というのが特徴として感じます。

ブラウザ上でプログラミングができ、

開発環境構築でのトラブルがない

という点が初心者に優しく、

ドットインストール

3分程度の短い動画で学べるサイトで、

テンポよく学習できます。

プログラミング言語だけでなく、

- フレームワーク

- インフラ

- ツール関連

など、

幅広く知識も学べるのが特徴です。

自分が気になるカテゴリの、

自分が気になる部分の内容だけでも、

動画を見るとヒントになることもあるので、

気になったものは見てみるという感じで使うのもオススメです。

Paizaラーニング

個人的な感覚ですが、

Progateとドットインストールを合わせたようなサイトで、

3分程度の短い動画で基礎を学んだ後、

ブラウザ上でコーディングが可能なので、

実際に手を動かしながら試せる

という点がすごくオススメなポイントです。

この手を動かして試せるという点は、

- 初心者がハマりやすい環境構築が不要

- 実際にコードを書くことでアウトプットの練習になる

ということが大きいので、

この点は実際に試してみてもらえると、

オススメポイントがわかっていただけると思います。

Codecademy

英語のサイトですが、

基礎的な英語力があれば利用可能かなと個人的には感じます。

私自身も英語音痴でしたが、

プログラミング自体はIT業界で取り組んできたので、

それを踏まえて、英語に慣れていきたいなと思った時に、

このサイトを見つけて少し取り組んでいました。

このサイトを使う中で、

- 英語なので、使っていく中で英語に慣れていく

- 指示に従ってコードを書くというトレーニングができる

という点が、

取り組んでいく中で身につけることができる可能性があるので、

プログラミングだけでなく、合わせて英語も取り組みたい

と考えている方にはオススメします。

CODEPREP

コーディング演習を提供し、

特に初心者向けのコンテンツが豊富です。

インタラクティブなコーディング演習が特徴です。

自分なりに考えて取り組んでいく要素があり、

- ヒントを見て自分なりに考える

- TIPSとして各種概要を理解する

という点が合わせてできるのが良いと感じています。

他のサービスに似た部分もありますが、

この構成や進め方が好きな人にはすごく合う

と感じています。

コンテンツ量も少しずつ増えていっているので、

最新コンテンツやサイトやサービスを確認してみると良いでしょう。

まとめ(おすすめサイト・サービス一覧)

[wpdatatable id=3]

Railsで初期テーブルデータをseedで設定

Railsでアプリケーションを作って、

そのアプリケーションを運営する中で、

現在のテーブルの項目を調整することは、

実際によくあることだと思います。

そんな中で、

- 既存のカラムを削除する

- 既存のカラムを変更する

- 新規のカラムを追加する

という時に、

既存のテーブルに対して、

変更を加えた際に、

rails db:migrate:resetなどを実行してしまうと、

全てのテーブルがクリアされてしまう。

以下の記事の中のコマンドです。

Railsでdb:migrate:resetがうまく動かなかった時の対応メモ

こちらの対応ではなく、

対象のテーブルだけ、

設定情報を反映させることが必要でした。

この時の対応は、

こちらの記事にメモしています。

今回は、

この対応の後に、

テーブルの初期データ作成のために、

seedでの処理を動かした時のメモです。

備忘録として記載しておきます。

Railsのマイグレーションの状況確認

まずは、

Railsのマイグレーションで作成したテーブルの、

作成状況をコマンドで確認します。

rails db:migrate:statusのコマンドを実行すると、

$ rails db:migrate:status

Running via Spring preloader in process 428491

database: sample

Status Migration ID Migration Name

--------------------------------------------------

up 20220101000000 Sample1

up 20220207000000 Sample2

up 20220207010000 Sample3

up 20220207020000 Sample4

up 20220207030000 Sample5

up 20220208000000 Sample6

up 20220222010000 Sample7

up 20220223000000 Sample8

このようにRailsのマイグレーションの状況が表示されます。

こちらを見てわかるように、

- Railsの各種テーブルのステータスが「up」の状態である

ということが言えます。

「down」だとうまくテーブル自体の作成が行われていないので、

まずは、こちらを確認、対応してください。

Railsでseedを使って初期テーブルデータを作成

先ほどのテーブルの一覧に対して、

必要なテーブルの初期データを設定します。

- 指定テーブルの初期データを「seeds.rb」に記載

- Railsコマンドで「seed」を実行

という手順で対応します。

設定ファイルとして、

「seeds.rb」

については、

db/seeds.rbにあるので、

こちらのファイルで初期設定データを準備してください。

Railsコマンドで初期データ追加

先ほどの初期データ設定ファイルを準備した上で、

実際のRailsコマンドを実行します。

基本は、

rails db:seedですが、

自分の環境に合わせて

rails db:seed RAILS_ENV=development

rails db:seed RAILS_ENV=testこのように環境指定することもできます。

実際に実行すると、

$ rails db:seed

Running via Spring preloader in process 2735808このように

実施された結果のプロセスIDが表示されるので、

データベースの方で実データを確認すると、

うまく初期データが追加されており、

問題なく処理が完了しました。

docker-composeでコンテナを立ち上げて、コンテナにアクセスするための流れをメモ

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

docker-compose

を使っているのですが、

対応後の問題の対応は記事等でメモしていましたが、

実際のファイル準備後の

docker-composeコマンドで立ち上げる際の手順

をよく忘れてしまうので、

自分の備忘録として、

忘れないうちにメモを残しておきます。

事前準備

ファイルとしては、

docker-compose.sample.ymlというファイルを準備します。

このファイルの中身自体のサンプルは、

また別途、気が向いたら、機会があれば、

記事としてシンプルなものを記載しようと思います。

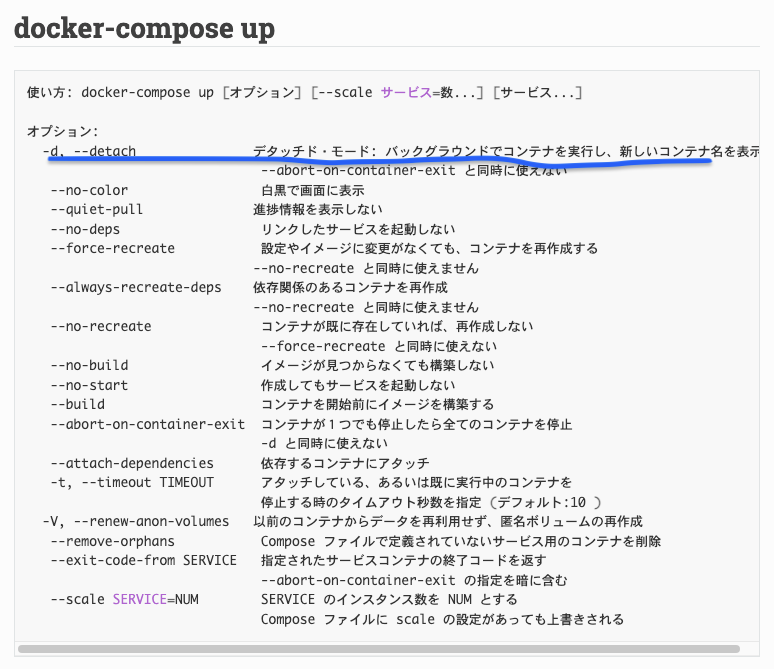

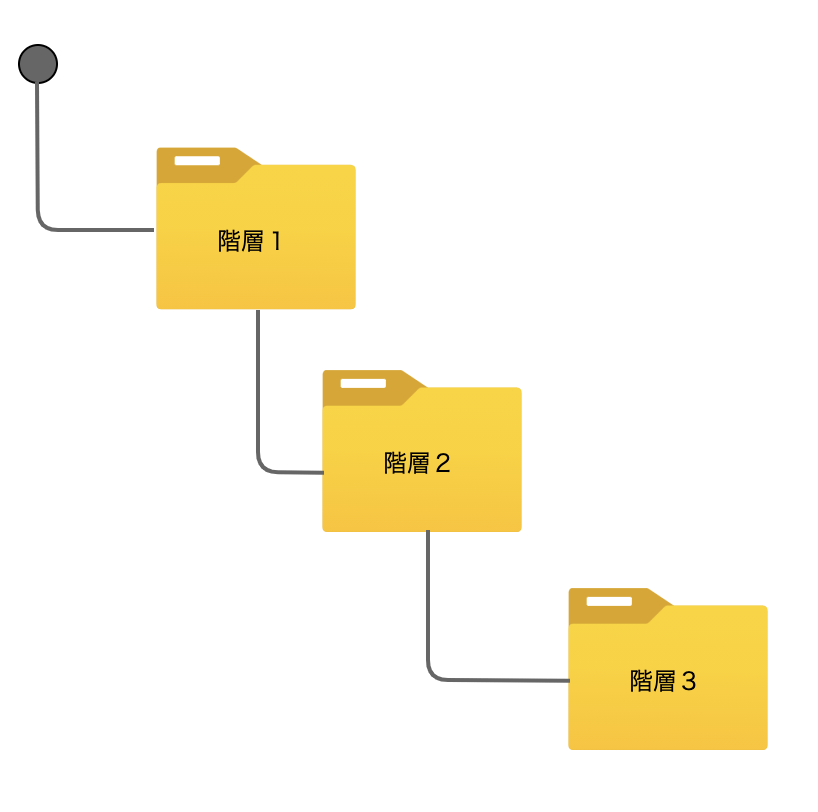

docker-composeコマンドでの立ち上げの流れ

立ち上げの流れとしては、

- 「build」コマンドでビルドを実施

- 「up」コマンドでコンテナを立ち上げ

という流れになります。

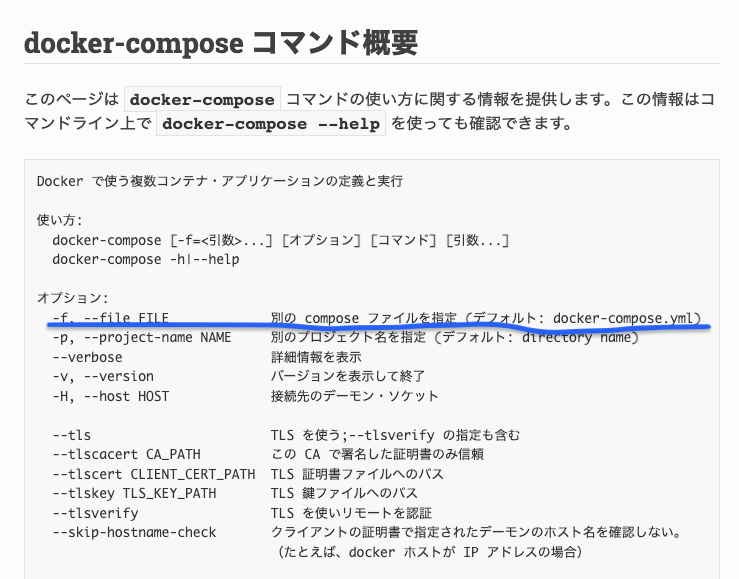

参考サイト

https://docs.docker.jp/compose/reference/overview.html

まずは、

「build」コマンドでビルドを実施

という対応を行います。

docker-composer -f docker-compose.sample.yml build上記の「-f」オプションは、

ファイル指定が必要なので、

オプションとして使用しています。

次に、

「up」コマンドでコンテナを立ち上げ

を行います。

コマンドとしては、

docker-composer -f docker-compose.sample.yml up -dという「up」コマンドで、

立ち上げを行っています。

ちなみに、

「-d」オプションについては、

このように、

バックグラウンドでの立ち上げオプションです。

ここまで実行できたら、

- Dockerコンテナの状況を確認する

という形で、

実際のDockerコンテナが立ち上がっているか、

コマンドを実行して確認します。

コマンド

docker psこちらで、

自分が作成したDockerコンテナが、

リストに表示されるので、

docker exec -it sample /bin/bashのように、

コンテナにアクセスすることができました。

こちらで、

うまくdocker-composeが挙動しましたので、

次回以降は忘れないように、

この記事を見ようと思います。

DockerコンテナのMySQLでクライアントで日本語データ確認したら文字化けしていたので調整

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

すでにMySQL用のコンテナを立ち上げており、

このMySQLへの各種アクセスや処理は問題ないのだが、

このコンテナ内のMySQLクライアントで、

接続してからデータを見ると文字化けする事象が発生。

その際に、試した時の対応を、

自分の備忘録として、

忘れないうちにメモを残しておきます。

関連内容

Dockerコンテナのネットワークについて、

確認するコマンドなどは、

以下の記事にメモしていますので参考にしてください。

事象メモ

実際のMySQLクライアントで、

データを確認を

select * from table_nameのように確認すると、

実際の値の表示が、

このように、

うまく文字列(日本語)が表示されなかった。

対応方法のメモ

今回の対応については、

MySQLコマンドで実行できました。

調整は、

- 現在の文字コードの状況を確認

- 文字コードを調整

という流れで、

まずは、確認から。

確認コマンド

SHOW VARIABLES LIKE 'character_set%';

SHOW VARIABLES LIKE 'collation%';確認結果

> SHOW VARIABLES LIKE 'collation%';

+----------------------+--------------------+

| Variable_name | Value |

+----------------------+--------------------+

| collation_connection | latin1_swedish_ci |

| collation_database | utf8mb4_0900_ai_ci |

| collation_server | utf8mb4_0900_ai_ci |

+----------------------+--------------------+確かに、

collation_databaseとcollation_serverがutf8mb4_0900_ai_ciに設定されており、

これはUTF-8の4バイト対応版であるutf8mb4の文字セットを使用していることを意味します。

これは、データベースとサーバーが日本語を含む多様な文字を適切に扱える設定になっています。

しかし、

collation_connectionがlatin1_swedish_ciになっているため、

クライアント(アプリケーション)と

MySQLサーバー間の接続で使用される文字セットがLatin1(西欧言語用)に設定されています。

これが原因で、日本語が正しく扱われずに文字化けしてしまう可能性があります。

調整としては、

utf8mb4_0900_ai_ciに変更します。

調整コマンド

SET NAMES utf8mb4 COLLATE utf8mb4_0900_ai_ci;こちらを実行して、

再度、

SHOW VARIABLES LIKE 'collation%';で確認すると、

> SHOW VARIABLES LIKE 'collation%';

+----------------------+--------------------+

| Variable_name | Value |

+----------------------+--------------------+

| collation_connection | utf8mb4_0900_ai_ci |

| collation_database | utf8mb4_0900_ai_ci |

| collation_server | utf8mb4_0900_ai_ci |

+----------------------+--------------------+となりうまく対応できました。

今回のMySQLクライアントだけで対応しているので、

コンテナ自体の設定を調整したわけではないので、

コマンド実行に際して、コンテナの停止は不要

という部分は、

今回の調整方法としては、

対応としてよかったのかなと思います。

コンテナ作成時に、

同じ事象が発生する点については、

別途、再立ち上げが必要なタイミングで、

調査対応を行おうと思います。

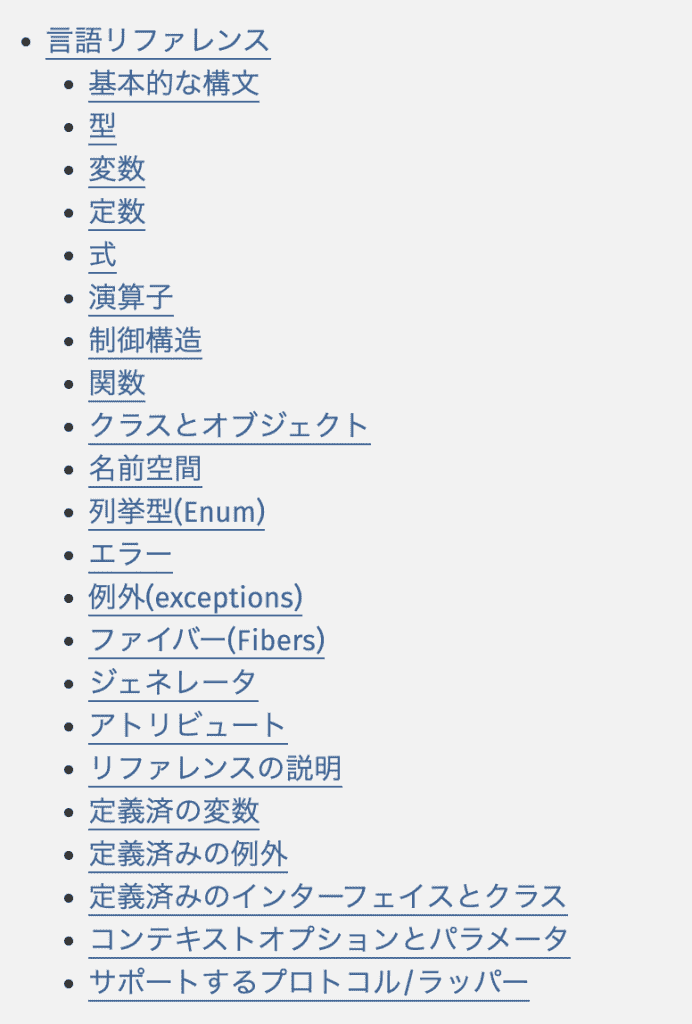

Laravelで「Allowed memory size of 134217728 bytes exhausted」でメモリサイズのエラーが発生した件

Laravelを使用していて、

必要なデータを集計して、

様々な処理を行うことがあります。

そんな時に、

ファイルダウンロードでエラーになることが発生しました。

この時のエラーについて、

確認方法をメモ。

Laravelのバージョン

Laravelのバージョンとしては、

php artisan --versionというコマンドで確認すると、

$ php artisan --version

Laravel Framework 10.13.5というバージョンであることがわかります。

発生した事象

ファイルをダウンロードする処理を行うと、

エラー内容が残っており、

以下のように、

メモリサイズのエラーが記載されていた。

Allowed memory size of xxxxxxxx bytes exhausted

xxxxxxxはエラーになったサイズ実際にこのエラーになったサイズでは、

メモリサイズの指定としては、

許容を超えているのでエラーというところ。

メモリサイズの設定

自分が動かしている環境では、

php8.1-fpmを使っているので、

以下の設定ファイルを変更する。

/etc/php/8.1/fpm/php.ini上記ファイルの中の

memory_limitのサイズを変更します。

ファイル内の、

メモリサイズ(memory_limit)を変更します。

memory_limit = xxxMxxxには任意のサイズを指定してもらって、

MByteでの指定をしています。

上記の設定変更が終わったら、

php8.1-fpmも再起動させます。

再起動コマンド

sudo service php8.1-fpm restartこちらで再度確認すると、

うまく処理が完了しましたので、

解決できました。

Dockerのネットワークに特定のコンテナを追加する方法

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

コンテナを立ち上げており、

最初から同じネットワークに入れておけばよかったけれど、

後からそのことに気づいきました。

その際に、

コマンドで、指定のネットワークに、

特定コンテナを追加する方法を調べて、

試した時の対応を、

自分の備忘録として、

忘れないうちにメモを残しておきます。

関連内容

Dockerコンテナのネットワークについて、

確認するコマンドなどは、

以下の記事にメモしていますので参考にしてください。

対応方法のメモ

今回の対応については、

コマンドで実行できました。

実行前の確認として、

上記の記事を参考に、

- ネットワーク一覧

- ネットワークの詳細

の2点を確認します。

ネットワークの一覧

docker network ls特定コンテナの詳細

docker network inspect [ネットワーク名]確認した結果、

"Containers": {

"xxxxxxx": {

"Name": "xxxxx",

"EndpointID": "xxxxxxxxx",

"MacAddress": "xxxxxxxxx",

"IPv4Address": "172.29.0.3/16",

"IPv6Address": ""

},

},このように、

調整前は1つのコンテナのみになっています。

その状態で、

以下のコマンドでネットワークに対して、

特定のコンテナを追加します。

ネットワークへの追加コマンド

docker network connect oms_app-network [コンテナ名]こちらを実行して、

再度、

ネットワークを確認してみると、

"Containers": {

"xxxxxxx": {

"Name": "xxxxx",

"EndpointID": "xxxxxxxxx",

"MacAddress": "xxxxxxxxx",

"IPv4Address": "111.22.0.3/16",

"IPv6Address": ""

},

"xxxxxxx": {

"Name": "xxxxx",

"EndpointID": "xxxxxxxxx",

"MacAddress": "xxxxxxxxx",

"IPv4Address": "111.22.0.4/16",

"IPv6Address": ""

},

},このように、

うまく特定のコンテナが、

指定のネットワークに追加されました。

試してみたところ、

コマンド実行に際して、コンテナの停止は不要

ということがわかったので、

誤ってネットワークに入れ忘れた時も、

この対応を行うことで解決できるかと思います。

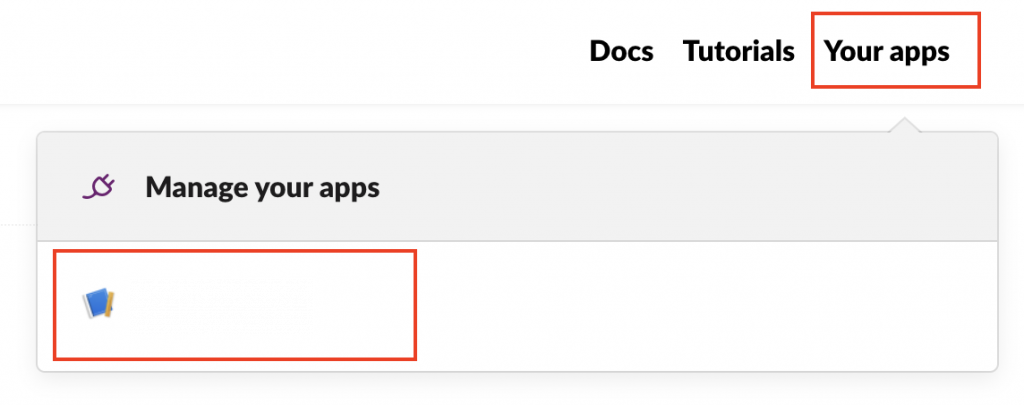

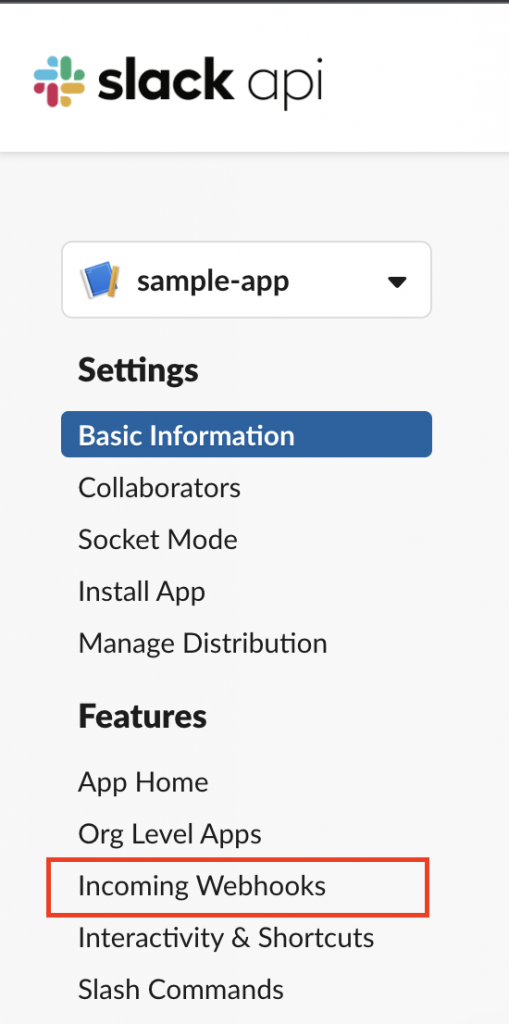

Slack API(Slack bolt)の環境設定情報の確認方法

Slackを使っていく中で、

APIを活用して、

便利に使用していこうとしています。

そんな中で、

Slack APIを活用していく中で、

Slack Boltのライブラリを活用して使用しています。

そんな中で、

環境設定値を確認するときに、

どこを確認して良いかわからなくなるので、

ゆくゆく同じことでハマりそうなのでメモ。

公式サイト

まずは、公式サイト。

リンク先を忘れるのでメモ。

以下あたりは注意したいところ。

🔒 全てのトークンは安全に保管してください。少なくともパブリックなバージョン管理にチェックインするようなことは避けるべきでしょう。また、上にあった例のように環境変数を介してアクセスするようにしてください。詳細な情報は アプリのセキュリティのベストプラクティスのドキュメントを参照してください。

Bolt公式サイトより引用

https://slack.dev/bolt-js/ja-jp/tutorial/getting-started

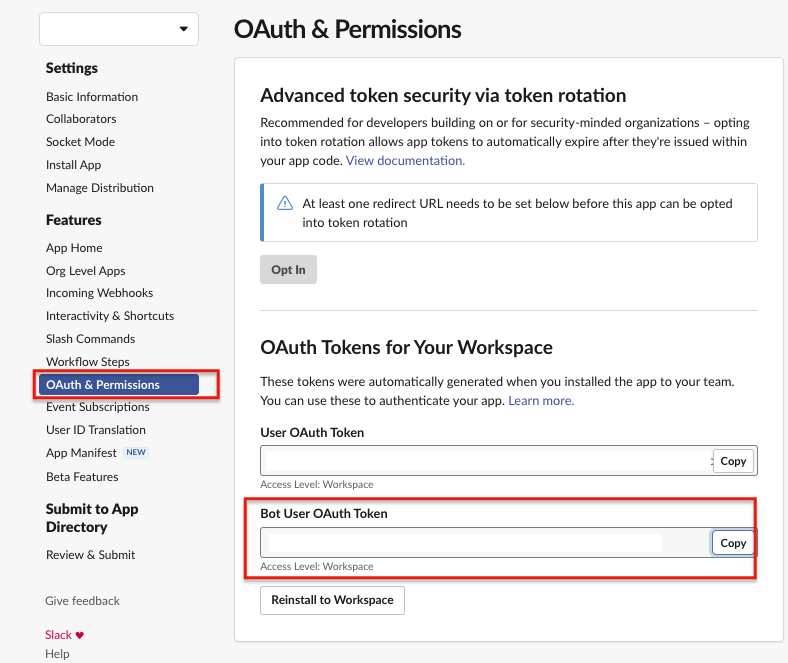

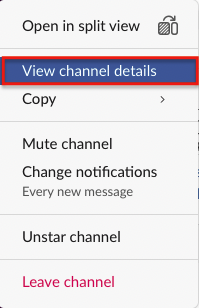

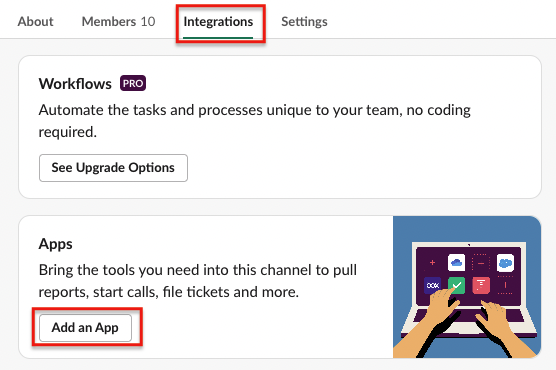

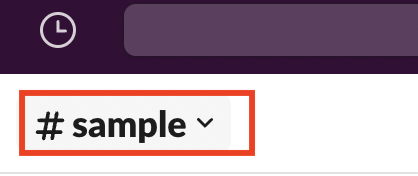

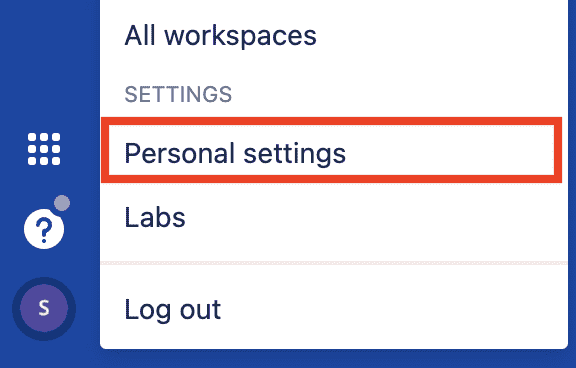

SLACK_BOT_TOKEN

公式サイトにも記載がある通り、

このように公式サイトに載っているので、

実際に確認してみます。

OAuth&Permissionsのページを確認すると、

実際に設定値がありました。

こちら赤枠部分が対象箇所ですね。

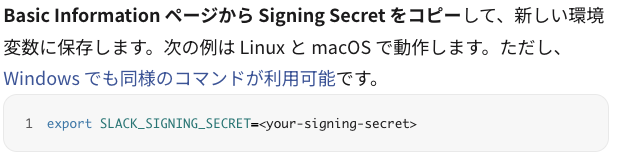

SLACK_SIGNING_SECRET

公式サイトにも記載がある通り、

このように記載がありますね。

公式サイトに載っているページを、

実際に確認してみます。

Basic Infomationのページを確認すると、

実際に設定値がありました。

こちら赤枠部分が対象箇所ですね。

Basic Infomationは項目も多いので、

対象箇所を間違えないように注意ですね。

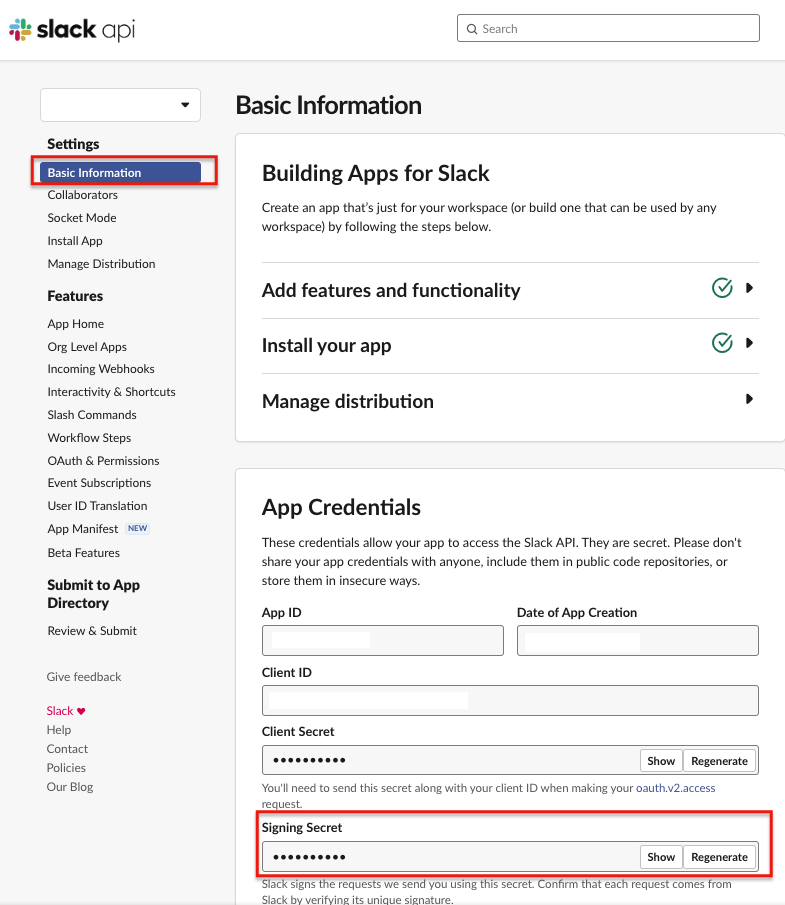

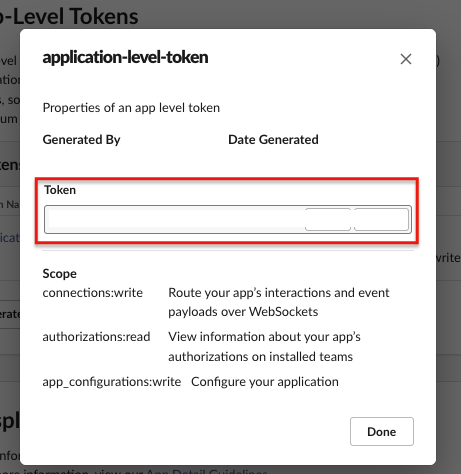

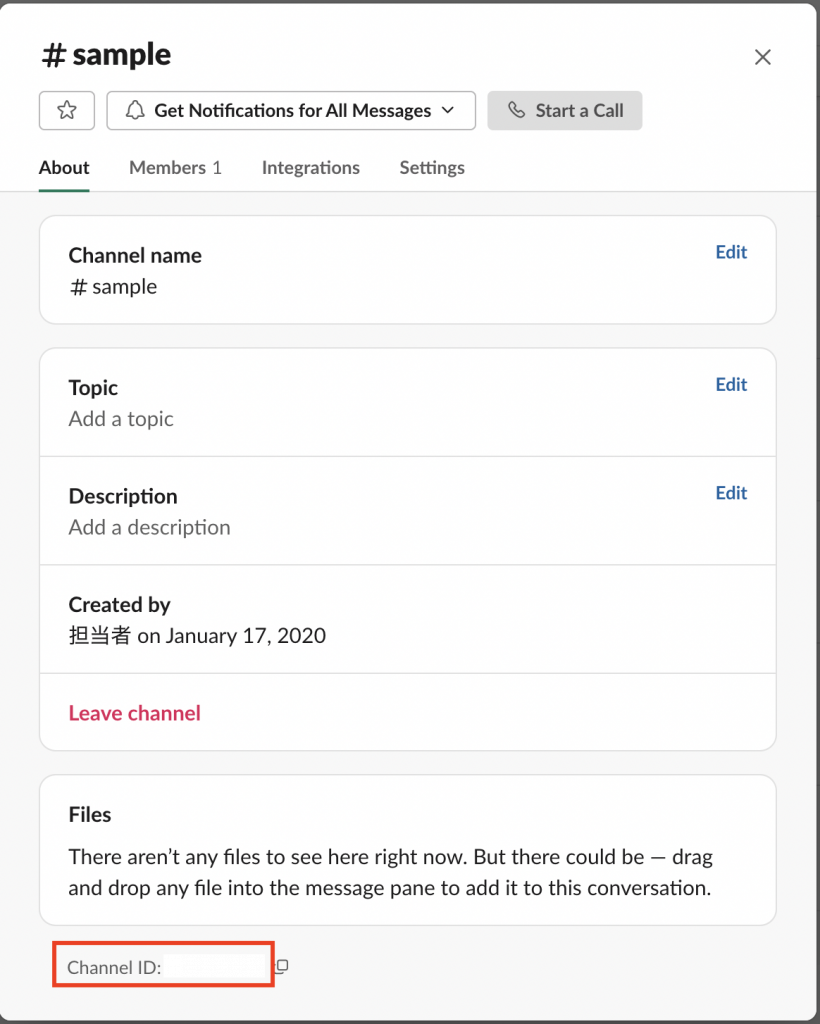

SLACK_APP_TOKEN

こちらのSLACK_APP_TOKENの設定値は、

公式サイトに具体的な場所の記載は見つけられませんでした。

(自分が見つけきれてないだけかもしれません)

実際にSlack APIのページから色々と確認したところ、

Basic Infomaitonページの中にありました。

設定自体は過去に設定はしていた気はしますが、

ここで確認するのかと。

画面表示としては、

このように、

先ほどのSLACK_SIGNING_SECRETを確認した箇所よりも、

下にスクロールしてもらうと、

上記画面部分があります。

こちらをクリックするとモーダルが開き、

このように、

SLACK_APP_TOKENのための値を

確認することができました。

よく忘れるので、またやる時にこれを見よう。

DockerホストからコンテナのアプリケーションにCurlでPOSTしたら動かなかった件

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

コンテナを立ち上げて、

その中のアプリケーションに対して、

ホストからcurlを使ってPOSTをしたけれど、

なぜか動かなかったので、

その時の対応を、

自分の備忘録として、

忘れないうちにメモを残しておきます。

起きた事象

ホストのアプリケーションから、

コンテナ内のアプリケーションに対して、

curlを使ってPOSTをしていました。

その時に、

- ホストからコンテナへのアクセス等は問題ない

- ホストからGETでの処理は問題ない

- ホストからPOSTでの処理が動かない

という事象が発生しました。

調査時のメモ

上記の起きた事象で、

もう少し細かく調べた時のメモ。

ホストから

コンテナ内のアプリケーションに、

curlでPOSTを実行した時、

ステータスは、

'http_code' => 200,のように正常系で終了。

コンテナ側のアプリケーションでログを確認したところ、

何もログが表示されなかった。

実際にPOSTのデータの中身に問題あるかと考え、

CurlのPOSTで送っているデータを空にしたところ、

データを空にするとうまく挙動する

ということがわかったので、

POSTデータサイズの影響で問題が起きている

ということがわかりました。

この辺りで、

今までの知見で、

自分が実行している環境では、

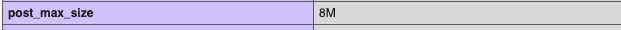

post_max_sizeの設定値がデフォルトの時に、

サイズ問題でエラーになったことが多かったので、

この部分の調整に取り掛かりました。

最終的な対応方法

先ほどのPOSTのサイズ問題を調整していきます。

実際に自分が動かしているPHPの環境では、

このようにサイズが初期状態でした。

動かしている内容が、

サイズ的にはこれを超えているので、

Docker内の設定を調整して反映させる

ということを行うことにしました。

設定ファイル

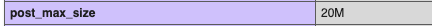

/usr/local/etc/php/php.ini変更箇所

post_max_size = 20M

memory_limit = 20M

upload_max_filesize = 20M上記に関して、

必要プロパティや他の必要なプロパティを追加。

こちらを反映させます。

反映方法としては、

Dockerを再起動することで反映させます。

再起動コマンド

docker restart [container id]上記で、

コンテナを再起動して、

実際の設定情報を確認してみます。

うまく変わっていますね。

こちらの状況で、

再度、

元々うまく動かなかった処理を動かすと、

問題なく処理動きました。

無事に解決できました。

Ubuntuでdocker-composeがエラー「command not found: docker-compose」

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

docker-compose

を使っているのですが、

特定のサーバーで環境を構築するために、

コマンドを実行したところエラーになりました。

その時の対応を、

自分の備忘録として、

忘れないうちにメモを残しておきます。

エラー内容

普段から、

docker-composeを使ってビルドをしていましたが、

別のサーバーでも環境を作ろうとして、

実行したところ、エラーが発生

実行コマンド

docker-compose -f docker-compose.sample.yml buildエラー内容

$ docker-compose -f docker-compose.sample.yml build

command not found: docker-composeということで、

docker-composeが見つからないとのこと。

最終的な対応方法

こちらはシンプルに、

サーバーにdockere-composeを導入

を行うことで解決しました。

解決するための過程等をメモ。

念のために、

Docker自体が動いているか確認。

確認コマンド

docker ps確認結果

$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMESこちらで、

Docker自体は問題ないですね。

それでは本題の方の、

docker-composeを導入します。

docker-composeのバイナリを取得します。

ベースのコマンドはこちらです。

sudo curl -L "https://github.com/docker/compose/releases/latest/download/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-composeこちらのコマンドで、

環境にあったバイナリが取得できると思いますが、

必要に応じて、

download/docker-compose-$(uname -s)-$(uname -m)"の部分で指定することで、

任意のバイナリを取得することも可能です。

のバージョンを調整してください。

取得できたら、

実行権限を調整します。

コマンド

sudo chmod +x /usr/local/bin/docker-composeこちらで権限の調整が終わるので、

実際にコマンドで確認してみましょう。

確認コマンド

docker-compose --version確認したところ、

$ docker-compose --version

Docker Compose version v2.23.0このように、

うまくdocker-composeが挙動しましたので、

無事に解決できました。

Dockerでエラー「dial unix /var/run/docker.sock: connect: permission denied.」

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

docker-compose

を使っているのですが、

特定のサーバーで環境を構築するために、

コマンドを実行したところエラーになりました。

その時の対応を、

自分の備忘録として、

忘れないうちにメモを残しておきます。

エラー内容

docker-composeを使ってビルドをしていましたが、

エラーになっているので、

そもそも、

Docker自体が動いているのかを確認してみました。

実行コマンド

docker psエラー内容

Got permission denied

while trying to connect to the Docker daemon socket

at unix:///var/run/docker.sock:

Get "http://%2Fvar%2Frun%2Fdocker.sock/v1.24/containers/json":

dial unix /var/run/docker.sock: connect: permission deniedということで、

Docker自体が正しく挙動していませんでした。

最終的な対応方法

いくか設定を変更したりしていましたが、

結論として、

権限を調整して、Dockerを再起動

を行うことで解決しました。

権限を調整

sudo usermod -aG docker $USERこちらで、

現在のユーザーをdockerグループに追加しています。

Dockerの再起動

sudo systemctl restart dockerこちらで、

先ほどの設定を反映するために、

Dockerのデーモンを再起動します。

もし、

SSHなどで接続している場合は、

現在のシェルに反映するためには、

- 現在のシェルに反映させるためにコマンドで対応

- 一度、ログアウトして、再度、SSHで接続

のどちらかが必要です。

直接、

現在のシェルに反映させるには、

以下のコマンドが必要です。

現在のシェルに反映させるコマンド

newgrp dockerここまでの対応を行うことで、

エラー自体が解決できました。

実際に、

docker psのコマンドで確認したところ、

$ docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMESこのように、

うまくDocker自体が挙動しましたので、

無事に解決できました。

エラー「ERROR: Version in “./docker-compose.authentication.yml” is unsupported.」

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

docker-compose

を使っているのですが、

別のサーバーに入って、

コマンドを実行したところエラーになりました。

その時の対応を、

自分の備忘録として、

忘れないうちにメモを残しておきます。

エラー内容

docker-composeを使ってビルドをしていました。

実行コマンド

docker-compose -f xxx.yml buildエラー内容

ERROR: Version in "./docker-compose.authentication.yml" is unsupported.

You might be seeing this error because you're using the wrong Compose file version.

Either specify a supported version (e.g "2.2" or "3.3")

and place your service definitions under the `services` key,

or omit the `version` key

and place your service definitions at the root

of the file to use version 1.

For more on the Compose file format versions,

see https://docs.docker.com/compose/compose-file/ということで、

上記に関して記載のある公式サイトのリンクはこちらです。

https://docs.docker.com/compose/compose-file/

最終的な対応方法

いくか設定を変更したりしていましたが、

結論として、

バージョンを確認時点の最新に変更

を行うことで解決しました。

古いバージョン

$ docker-compose -v

docker-compose version 1.25.0こちらのバージョンを、

新しいバージョン

$ docker-compose -v

docker-compose version 1.29.1になるように調整することで、

エラー自体が解決できました。

この時のバージョンアップの具体的な方法は、

以下の記事にメモしています。

docker-composeのバージョンのアップデート

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

docker-compose

を使っているのですが、

このバージョン自体を上げたい環境があり、

その時のコマンドを、

自分の備忘録として、

忘れないうちにメモを残しておきます。

docker-composeのバージョンを確認

以下のコマンドで確認していきます。

確認コマンド

docker-compose -v確認結果

$ docker-compose -v

docker-compose version 1.25.0こちらで、

現在のバージョンが1.25.0であることがわかります。

docker-composeのバージョンアップの方法

先ほどのバージョンから、

バージョンを確認時点の最新に変更します。

古いdocker-compose自体を削除

rm -rf docker-composeバージョン指定で取得

sudo curl -L "https://github.com/docker/compose/releases/download/1.29.1/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose権限を調整

sudo chmod +x /usr/local/bin/docker-compose上記をしたあと、

SSHで接続をしているので、

1度、ログアウトしてから、再度ログインしました。

こちらでバージョンを再確認します。

確認コマンド

docker-compose -v確認結果

$ docker-compose -v

docker-compose version 1.29.1こちらでうまくバージョンがアップデートできました。

Docker+Python3+Seleniumで「chromedriver unexpectedly exited. Status code was: 255」

Docker上に、Python3.8ベースで環境を作り、

seleniumで試そうとしていたところ、

うまくいかない事象が起きて、

エラーが起きたのでメモを残す。

個人的な備忘録のために、

この記事に残しておく。

エラー内容メモ

コンテナ内で、

seleniumを立ち上げる中で、

chromedriverの処理として、

try:

self.driver = webdriver.Chrome(options=chrome_options)

except Exception as e:

print(f"An error occurred: {str(e)}")この部分でエラーを確認すると、

An error occurred:

Message:

Service /root/.cache/selenium/chromedriver/linux64/118.0.5993.70/chromedriver

unexpectedly exited.

Status code was: 255このようなエラーが発生。

参考サイト

以下の2つ。

https://qiita.com/ma-me/items/090c3e9befc31e68f063

https://github.com/googlecolab/colabtools/issues/3347

個人用のコードメモ

上記サイトを参考に、

以下のコードを作って実行。

vi update_selenium_for_debian.sh#!/bin/bash

# Ubuntu no longer distributes chromium-browser outside of snap

#

# Proposed solution: https://askubuntu.com/questions/1204571/how-to-install-chromium-without-snap

# Add debian buster

cat > /etc/apt/sources.list.d/debian.list <<'EOF'

deb [arch=amd64 signed-by=/usr/share/keyrings/debian-buster.gpg] http://deb.debian.org/debian buster main

deb [arch=amd64 signed-by=/usr/share/keyrings/debian-buster-updates.gpg] http://deb.debian.org/debian buster-updates main

deb [arch=amd64 signed-by=/usr/share/keyrings/debian-security-buster.gpg] http://deb.debian.org/debian-security buster/updates main

EOF

# Add keys

apt-key adv --keyserver keyserver.ubuntu.com --recv-keys DCC9EFBF77E11517

apt-key adv --keyserver keyserver.ubuntu.com --recv-keys 648ACFD622F3D138

apt-key adv --keyserver keyserver.ubuntu.com --recv-keys 112695A0E562B32A

apt-key export 77E11517 | gpg --dearmour -o /usr/share/keyrings/debian-buster.gpg

apt-key export 22F3D138 | gpg --dearmour -o /usr/share/keyrings/debian-buster-updates.gpg

apt-key export E562B32A | gpg --dearmour -o /usr/share/keyrings/debian-security-buster.gpg

# Prefer debian repo for chromium* packages only

# Note the double-blank lines between entries

cat > /etc/apt/preferences.d/chromium.pref << 'EOF'

Package: *

Pin: release a=eoan

Pin-Priority: 500

Package: *

Pin: origin "deb.debian.org"

Pin-Priority: 300

Package: chromium*

Pin: origin "deb.debian.org"

Pin-Priority: 700

EOF

# Install chromium and chromium-driver

apt-get update

apt-get install chromium chromium-driver

# Install selenium

pip install selenium作ったら、

sh update_selenium_for_debian.shを実行する。

その後、アプリケーション再起動で完了。

Pythonのbottleで作ったものをコンテナで立ち上げるとアクセスできなかった件

Pythonのbottleで、

各種処理を作っており、

今までの環境では、

Nginxをベースに、

サーバー上で直接起動させていた。

環境整備の一環で、

Dockerを使うようになって、

既存アプケーションを、

コンテナに移していく中で、

このbottleで作ったアプリケーションに、

なぜかうまくアクセスできない事象が発生。

この事象について、

個人的な備忘録のために、

この記事に残しておく。

既存アプリケーションの立ち上げ方

ルーティングなどを、

route.pyとして作っており、

python3 route.pyで立ち上げるようにしていた。

こんな感じ。

from bottle import Bottle, request, response, route, run, template

:

if __name__ == '__main__':

from optparse import OptionParser

parser = OptionParser()

parser.add_option("--host", dest="host", default="localhost",

help="hostname or ip address", metavar="host")

parser.add_option("--port", dest="port", default=8080,

help="port number", metavar="port")

(options, args) = parser.parse_args()

run(app, host=options.host, port=int(options.port))コンテナに移して起きた事象

コンテナを立ち上げ、

ポートフォワードは、

0.0.0.0:8080->8080/tcpこのようになるように設定している。

コンテナで8080はすでに立ち上げている。

この時に、アクセス状況としては、

以下のようになった。

コンテナ内からのアクセス

コンテナ内で、

curl -l http://localhost:8080でアクセスを確認すると、

問題なくアクセスできました。

コンテナ外(ホスト)からのアクセス

コンテナ外(ホスト)で、

curl -l http://localhost:8080でアクセスを確認すると、

curl: (52) Empty reply from serverとレスポンスが空になり、

コンテナ内でアクセスきているのか、

ログを確認してみても、

アクセスされていませんでした。

設定ミスを調整

上記以外にも、シンプルなアプリケーションで、

コンテナ立ち上げ、ポートフォワードのアクセス確認をしたところ、

bottleアプリケーションでブロックしている可能性が高い

という状況判断しました。

この判断して詳しく調べていくと、

from bottle import Bottle, request, response, route, run, template

:

if __name__ == '__main__':

from optparse import OptionParser

parser = OptionParser()

parser.add_option("--host", dest="host", default="localhost",

help="hostname or ip address", metavar="host")

parser.add_option("--port", dest="port", default=8080,

help="port number", metavar="port")

(options, args) = parser.parse_args()

run(app, host=options.host, port=int(options.port))このコードの中で、

parser.add_option("--host", dest="host", default="localhost",となっていますが、

これが、

localhost

となっているので、

コンテナ内からのみアクセスが可能になっていました。

そのため、

この部分を、

0.0.0.0

に変更します。

parser.add_option("--host", dest="host", default="0.0.0.0",このように調整して、

アプリケーションを立ち上げ直すことで、

うまくホスト側からでもアクセスできました。

シンプルな事象ですが、

今後のためにもメモしておきます。

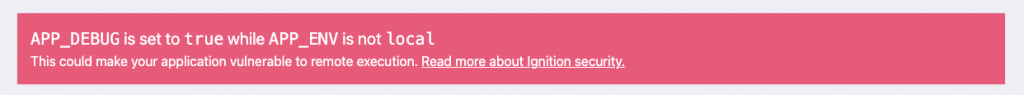

Next.jsで「no_secret」のエラー発生

Nextjsで実装していたときに、

Dockerコンテナで立ち上げて、

検証環境に色々と試していたのだが、

上記の画像のようなエラーが発生した。

最初に設定情報をこの環境に入れるのを忘れて、

その後に調整してコンパイルしたのだが、

最初にコンパイルした時のゴミが残り続けた影響な気もする。

今後のために

個人的な備忘録としてこの記事に残します。

エラー内容

エラーに関しては、

このようなエラー表示になっていた。

実際のログを確認すると、

以下のようにログが表示されていた。

no_secret Please define a `secret` in production. MissingSecret

[MissingSecretError]: Please define a `secret` in production.設定ファイル周りで、secretファイルは、

開発環境などでは問題なく設定・動作しているので、

基本的に影響はないとは思うが、

1つの調整方法として、

以下を試したのでメモ。

ファイル

pages/api/auth/[...nextauth].js調整箇所

直接、secret設定を追加。

ただし、開発環境では、なくても動いたので不要なのかもしれない

export const authOptions = {

:

secret: process.env.NEXTAUTH_SECRET

}参考

再コンパイルが反映されていなかった?

プロセス常駐していたのだが、

こちらを停止して、

色々と確認している中で、

npm run devで試しにコンパイルではなく、

シンプルに立ち上げて確認しようとすると、

Error: listen EADDRINUSE: address already in use :::3000というエラーが発生した。

そのため、

使用ポートを確認するコマンド

lsof -i :3000こちらでプロセスIDを確認して、

kill -9 [process-id]でプロセスを終了させて、

再度、起動させるとうまく挙動した。

どちらかというと、

こちらの3000ポートが、

停止しても残り続けていたのが影響していたのかもしれない。

Dockerコンテナのネットワーク状況の確認コマンド

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

複数コンテナを扱う上で、

個人的に使うコンテナのネットワークを確認するコマンドを

自分の備忘録として、

忘れないうちにメモを残しておきます。

Dockerコンテナでよく使うコマンド

コンテナ一覧

docker ps対象コンテナへの接続

docker exec -it [docker name or id] /bin/bashDockerコンテナのネットワーク状況確認のコマンド

複数コンテナを扱う中で、

ネットワークの扱いを確認するときに、

確認するコマンドを調べて、

よく確認するようになったので、

忘れないうちにメモ。

ネットワーク一覧

docker network ls対象ネットワークの詳細を確認

docker network inspect [network name]対象ネットワークの削除

docker network rm [network name]すべてのネットワークの削除

docker network pruneDocker Desktop For Macの導入と基本動作

Dockerの立ち上げに関しては、

- Dockerfileというファイルを作成する

- ビルドしてDockerイメージを作成する

- Dockerイメージからコンテナを作成する

- コンテナに接続してログインする

という手順を行って、

上記をやってみたあとに、

- Dockerのイメージの確認

- Dockerのコンテナの確認

- Dockerのコンテナの停止と削除

などを行っていました。

この辺りは、

コマンドで実行したことがあるので、

その辺りは、

【簡易サンプル】Dockerの基本的な手順とコマンドサンプル

こちらを参考にしてください。

今回は、

GUIを使う時の画面操作のメモを残すために、

Docker Desktop For Mac

を使って、

画面操作した時のメモを残しておきます。

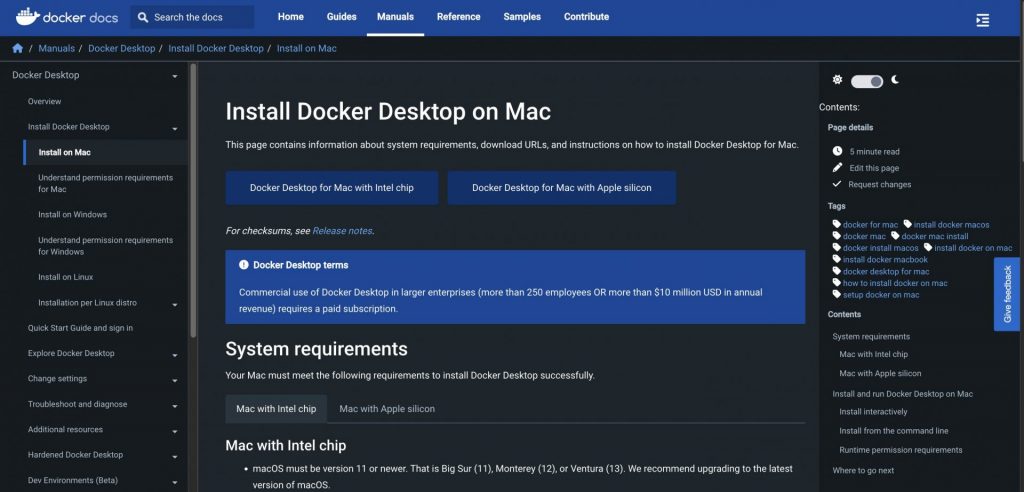

Docker Desktop For Macのインストール

まずは、

Docker Desktop For Mac

をパソコンにインストールします。

インストールするには、

以下のリンクから、

dmgファイルをダウンロードします。

上記のページで、

この画面で、

- Docker Desktop for Mac with Intel chip

- Docker Desktop for Mac with Apple silicon

を選んで、

インストールします。

自分自身のパソコンのチップを確認して、

どちらかをインストールします。

状況によっては、既存フォルダを削除

既存で1回入れたことがあるなど、

古いdocker関係の環境があると、

Docker Desktop For Macを起動しようとするときに、

エラーになってしまうことがあります。

自分自身も最初に起きたので、

rm ~/.dockerを削除すると、

うまく起動することができました。

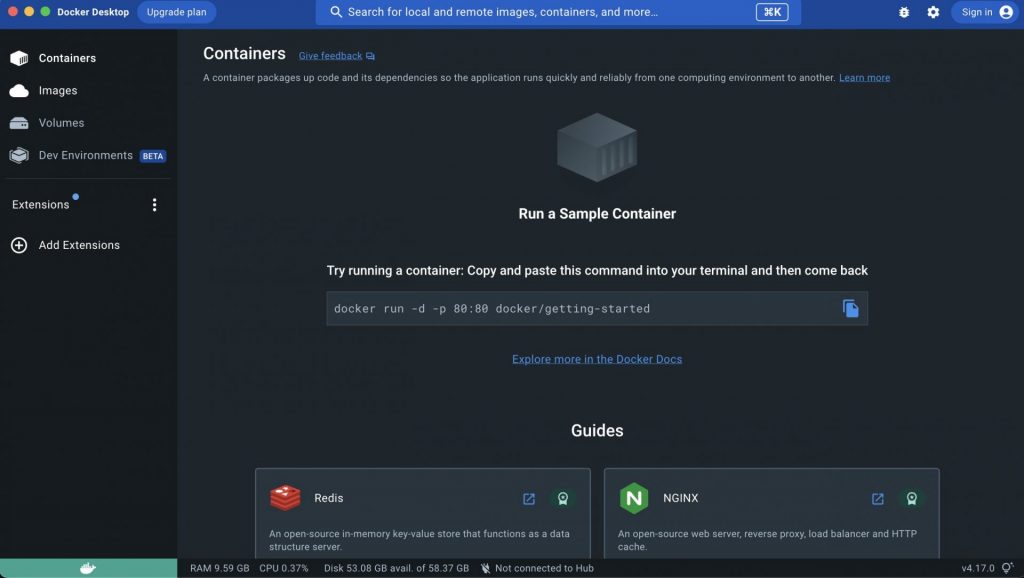

Docker Desktop For Macを起動

実際に、

Docker Desktop For Macを起動

$ docker ps

CONTAINER .... PORTS NAMES

111 .... 0.0.0.0:8080->10000/tcp, :::8080->10000/tcp testエラー内容

エラー内容としては、

サーバーの中(Dockerの外)から、

curlコマンドで実行を確認すると、

確認コマンド

curl -l http://localhost:8080/test確認結果

$ curl -l http://localhost:8080/test

curl: (52) Empty reply from serverという感じで、

「Empty reply from server」

というエラーが発生しました。

Dockerの中で、

「10000」というポートで立ち上げたサーバーの中で、

このポートにアクセスできるか確認すると、

$ curl -l http://localhost:10000/test

test ←これは検証で試した返却値という形で、

問題なくレスポンスが返却されていました。

対応方法

解決方法としては、

Docker内で起動しているサーバーのホスト名を、

「localhost」ではなく「0.0.0.0」

に変更するとうまく動作しました。

Dockerの外から、

$ curl -l http://localhost:8080/test

curl: (52) Empty reply from serverというエラーになっていたものが、

$ curl -l http://localhost:10000/test

curl: (52) Empty reply from serverというレスポンスになっているので、

うまく挙動していることが確認できました。

PythonからMySQLへの実行で「Not all parameters were used in the SQL statement」のエラー

今回は、

PythonでMySQLのレコードの追加時に、

Not all parameters were used in the SQL statementのエラーが発生して、

うまくデータの追加処理ができない事象が発生した。

この対応を行った際に、

うまく調整できずに、

単純なことなのにハマっていたので、

個人用の備忘録としてメモを残しておきます。

使用したMySQLのバージョン確認

mysqlのコマンドラインで確認

mysql -V実行結果

$ mysql -V

mysql Ver 8.0.31-0ubuntu0.20.04.1 for Linux on x86_64 ((Ubuntu))実行時のエラーログと対応方法

実際に実行した時の、

エラーログをメモ。

<class 'mysql.connector.errors.ProgrammingError'>,

ProgrammingError(-1,

'Not all parameters were used in the SQL statement',

None), こちらのエラーで、

私のやってきた状況としては、

今までは正常に動いていたのだけれど、

しばらく放置していて、

久しぶりに処理を動かしてみたところ、

エラーになっていた。

こちらを確認すると、

自分の場合はシンプルに、

実際のカラム数と実行時のカラム数が異なっていた

ということだったので、

Pythonのレコード追加の処理の部分を調整したらうまくいった。

今後、カラム追加したときは、

この辺りも注意すること。

メモ、以上。

Reactで配列をmapで繰り返しながら表示しようとするとレンダリングで何も表示されなかった件

Nextjsで実装していたときに、

JavaScriptのmapの処理で、

繰り返しながらレンダリングして、

描画をさせようとした時に、

なぜか描画されない事象が発生した。

ちょっとしたコードの書き方だが、

個人的にハマって時間を使ってしまったので、

今後のために

個人的な備忘録としてこの記事に残します。

うまくいかないパターン

配列を

const numbers = [1, 2, 3, 4, 5];このように準備して、

mapで繰り返した時の書き方で、

以下の書き方ではうまくレンダリングされなかった。

{

numbers.map((number) => {

<>{number}</>

})

}うまくいったパターン

上記のコードを調整して、

変更後のコードはこちら。

{

numbers.map((number) =>

<>{number}</>

)

}LaravelのQueueで「XXXX has timed out.」でタイムアウトのエラーが発生した件

Laravelを使用していて、

Queueを用いることで、

様々な処理を行うことがあります。

そんな時に、

なぜかQueueがエラーになることが発生しました。

この時のエラーについて、

確認方法をメモ。

Laravelの公式情報

関連するQueueの情報については、

以下の公式サイトを参照

https://laravel.com/docs/10.x/queues#dealing-with-failed-jobs

Laravelのバージョン

Laravelのバージョンとしては、

php artisan --versionというコマンドで確認すると、

$ php artisan --version

Laravel Framework 10.13.5というバージョンであることがわかります。

発生した事象

QueueのFailed用のテーブルに、

エラー内容が残っており、

以下のように、

exceptionのカラムにタイムアウトエラーが記載されていた。

XXXX has timed out.タイムアウト時間の設定

デフォルトの内容に関しては、

公式サイトに以下のように記載がある。

Often,

you know roughly how long you expect your queued jobs to take.

For this reason,

Laravel allows you to specify a "timeout" value.

By default, the timeout value is 60 seconds.

If a job is processing for longer than

the number of seconds specified by the timeout value,

the worker processing the job will exit with an error.

Typically,

the worker will be restarted automatically

by a process manager configured on your server.上記に記載がある通り、

By default, the timeout value is 60 seconds. とのことなので、

こちらを調整する必要がある。

こちらは、

Queueの実行時に、

オプションとしてタイムアウトの時間を設定できる

php artisan queue:work --timeout=300こちらで、

実行時間が300秒に変わるので、

必要に応じてタイムアウト時間を調整すると良いでしょう。

LaravelのQueueのエラーログを確認する方法

Laravelを使用していて、

Queueを用いることで、

様々な処理を行うことがあります。

そんな時に、

なぜかQueueがエラーになることが発生しました。

この時のエラーについて、

確認方法をメモ。

Laravelの公式情報

関連するQueueの情報については、

以下の公式サイトを参照

https://laravel.com/docs/10.x/queues#dealing-with-failed-jobs

Laravelのバージョン

Laravelのバージョンとしては、

php artisan --versionというコマンドで確認すると、

$ php artisan --version

Laravel Framework 10.13.5というバージョンであることがわかります。

発生した事象

Queueの処理を行っていたのだが、

Laravel内のモデルの処理で、

なぜか途中で停止してしまう。

また、

停止されると、

Jobsのテーブルからも削除されていた。

Queueのエラー(失敗時)のログ確認

確認したい内容としては、

エラー時(失敗時)のログとして、

理由が知りたかったので、

そちらについては、

Queueのfailed用のテーブルがあるので、

そちらを準備して実行すると確認できます。

php artisan queue:failed-tablephp artisan migrateこちらで、

failed_jobsというテーブルが作成されるので、

実行すると、

エラー時(失敗時)の内容が、

そちらに記載されるので、

内容を確認すると良いでしょう。

SSHの設定

SSHの設定に関して、

VPSや各種クラウド上のサーバー等で、

設定していた時のメモ。

個人用の備忘録として残しておきます。

SSHの設定ファイル

設定ファイル

/etc/ssh/sshd_configVimでの修正

vi /etc/ssh/sshd_configリロード

sudo systemctl restart sshSSH設定内容

Rootユーザーのログイン許可

Rootユーザーでのログインを許可または禁止する

対象プロパティ

PermitRootLogin設定例(禁止設定)

PermitRootLogin noパスワード認証の許可・禁止

パスワードでの認証を許可または禁止する

対象プロパティ

PasswordAuthentication設定例(禁止)

PasswordAuthentication no公開鍵認証の許可・禁止

公開鍵認証での認証を許可または禁止する

コメントアウトされている時のデフォルトはyes。

対象プロパティ

PubkeyAuthentication設定例(禁止)

PubkeyAuthentication yesTypeScriptで「Type error: Argument of type ‘String’ is not assignable to parameter of type ‘string’.」エラーの件

Nextjsで実装していたときに、

TypeScriptを取り入れて、

コードを変更していた際に、

調整していた時のメモ。

発生したのは、

Type error:

Argument of type 'String' is not assignable

to parameter of type 'string'.

'string' is a primitive,

but 'String' is a wrapper object.

Prefer using 'string' when possible.のエラーが発生。

このエラーを対応した時のメモ。

個人的な備忘録としてこの記事に残します。

エラー

Next.jsで、

TypeScriptを導入して、

コード調整した上でコンパイルするために、

以下のコマンドを実行

npm run build調整内容

上記のエラー内容を見てみると、

Type error:

Argument of type 'String' is not assignable

to parameter of type 'string'.

'string' is a primitive,

but 'String' is a wrapper object.

Prefer using 'string' when possible.という表示。

他のコードと同じように、

TypeScriptを導入して、

型定義の対応が漏れているので調整が必要。

コードの中で、

- String(先頭大文字)

- string(先頭小文字)

この2つでは、

型の扱いが違うので、

その点を調整。

詳しくは、

TypeScriptのStringとstringは何が違うのか

を参照。

調整前

const sample = (sampleText: String) => {

:

}調整後

const sample = (sampleText: string) => {

:

}上記で対応。

TypeScriptで「Type error: Property ‘value’ does not exist on type ‘EventTarget’.」エラーの件

Nextjsで実装していたときに、

TypeScriptを取り入れて、

コードを変更していた際に、

調整していた時のメモ。

発生したのは、

Type error: Property 'value' does not exist on type 'EventTarget'.のエラーが発生。

このエラーを対応した時のメモ。

個人的な備忘録としてこの記事に残します。

関連調整

関連調整としては、

以下の記事の対応部分に関連。

TypeScriptで「Type error: Parameter ‘event’ implicitly has an ‘any’ type.」エラーの件

TypeScriptで「Type error: ‘event.target’ is possibly ‘null’.」エラーの件

エラー

Next.jsで、

TypeScriptを導入して、

コード調整した上でコンパイルするために、

以下のコマンドを実行

npm run build調整内容

上記のエラー内容を見てみると、

Type error: Property 'value' does not exist on type 'EventTarget'.という表示。

他のコードと同じように、

TypeScriptを導入して、

型定義の対応が漏れているので調整が必要。

Eventの中の特定プロパティの中で、

さらにvalueのプロパティを取得しようとしていたので、

その点を調整。

調整前

const sampleActions = (event: Event) => {

:

if(event.target) {

console.log(event.target.value);

}

}調整後

const sampleActions = (event: Event) => {

:

if(event.target) {

const target = event.target as HTMLInputElement;

console.log(target.value);

}

}上記で対応。

TypeScriptで「Type error: ‘event.target’ is possibly ‘null’.」エラーの件

Nextjsで実装していたときに、

TypeScriptを取り入れて、

コードを変更していた際に、

調整していた時のメモ。

発生したのは、

Type error: 'event.target' is possibly 'null'.のエラーが発生。

このエラーを対応した時のメモ。

個人的な備忘録としてこの記事に残します。

関連調整

関連調整としては、

以下の記事の対応部分に関連。

TypeScriptで「Type error: Parameter ‘event’ implicitly has an ‘any’ type.」エラーの件

エラー

Next.jsで、

TypeScriptを導入して、

コード調整した上でコンパイルするために、

以下のコマンドを実行

npm run build調整内容

上記のエラー内容を見てみると、

Type error: 'event.target' is possibly 'null'.という表示。

他のコードと同じように、

TypeScriptを導入して、

型定義の対応が漏れているので調整が必要。

Nullデータである可能性があるので、

その点を判定処理して対応させる。

調整前

const sampleActions = (event: Event) => {

:

}調整後

const sampleActions = (event: Event) => {

:

if(event.target) {

:

}

}上記で対応。

TypeScriptで「Type error: Parameter ‘event’ implicitly has an ‘any’ type.」エラーの件

Nextjsで実装していたときに、

TypeScriptを取り入れて、

コードを変更していた際に、

調整していた時のメモ。

発生したのは、

Type error: Parameter 'event' implicitly has an 'any' type.のエラーが発生。

このエラーを対応した時のメモ。

個人的な備忘録としてこの記事に残します。

エラー

Next.jsで、

TypeScriptを導入して、

コード調整した上でコンパイルするために、

以下のコマンドを実行

npm run build調整内容

上記のエラー内容を見てみると、

Type error: Parameter 'event' implicitly has an 'any' type.という表示。

他のコードと同じように、

TypeScriptを導入して、

型定義の対応が漏れているので調整が必要。

調べた時の参考

TS7006: Parameter ‘event’ implicitly has an ‘any’ types

上記にも記載があるが、

自分の環境のコードだと、

調整前

const sampleActions = (event) => {

:

}調整後

const sampleActions = (event: Event) => {

:

}上記で対応。

Lintで「Warning: React Hook useEffect has missing dependencies:」エラーの件

Nextjsで実装していたときに、

Lintチェックをしたときに、

Warning: React Hook useEffect has missing dependencies:

'xxxxxx' and 'xxxxxx'.

Either include them or remove the dependency array.

react-hooks/exhaustive-depsのエラーが発生。

このエラーを対応した時のメモ。

個人的な備忘録としてこの記事に残します。

Lint実行コマンド

Next.jsで、Lintでコード確認したいので、

以下のコマンドを実行

npm run lintエラー内容

先ほども記載した通り、

上記のLintを実行すると、

Warning: React Hook useEffect has missing dependencies:

'xxxxxx' and 'xxxxxx'.

Either include them or remove the dependency array.

react-hooks/exhaustive-depsこのような表示が出ていた。

調整内容

上記のエラー内容を見てみると、

Warning: React Hook useEffect has missing dependencies:

'xxxxxx' and 'xxxxxx'.

Either include them or remove the dependency array.

react-hooks/exhaustive-depsの中で、

依存関係周りがうまくいっていないので、

- 対象を依存関係に含める

- 依存関係の配列を削除

のどちらかを対応する必要があるらしい。

上記に関して、

useEffectの依存関係を調整。

調整前

useEffect(() => {

:

}, []);調整後

useEffect(() => {

:

});上記のように、

依存設定自体の配列を消す対応を行った。

こちらで、

Lintのエラー表示が消えました。

Vue+TypeScirptでPromise.allをaxiosで並列実行を試した件

Vue+TypeScriptをフロントエンドで使う中で、

APIの処理を並列処理させたいと考え、

Promise.allを使って、

処理を実装する方法があることを知り、

そちらを試した時のメモ。

処理の実装部分で、

自分自身の環境において、

色々と試したいことがあったので、

そちらについても、

今後のためにメモを残す。

Vueのバージョンについても、

バージョン2系ではなく、

バージョン3系を導入して、

Vue+TypeScriptの構成で試している。

個人用の備忘録としてメモを残しておく。

色々と試しながら、

挙動を確認している感じなので、

この記事に関しては、

必要に応じて、

記事追記、または別記事を追加。

Promise.allの実装時の参考記事メモ

こちらの実装に関しては、

こちらのサイトを参考にしました。

リンクをメモ。

Aggregate Multiple API Requests with Promise.all()

Promise.allを使った部分のベースコード

上記の参考記事などをベースに、

Promise.allを使ったコードは、

axiosを使うとすると、

以下のようなコードになります。

await Promise.all([

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

])

.then((response) => {

console.log(response);

})

.catch(function (response) {

console.log(response);

});エラー「TypeError: Cannot read properties of undefined (reading ‘post’)」の対応

上記のコードをベースにしたときに、

エラーとして、

TypeError: Cannot read properties of undefined (reading 'post')が起こりました。

こちらに関しては、

https://github.com/axios/axios/issues/5262

対策で試したことは、

- axiosのバージョンを0.27.2以降に調整

- axiosのデフォルト設定を処理に追加

の2つを調整で試みました。

バージョンは、

NPMパッケージで調整してもらえると良いので、

そちらで調整を完了させ、

デフォルト設定についても、

上記サイトの内容を参考に調整しました。

調整したコードとしては、

const axios = require('axios').default;

await Promise.all([

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

])

.then((response) => {

console.log(response);

})

.catch(function (response) {

console.log(response);

});このようなコードになります。

自分の環境では、

getではなくpostで試したので、

そのあたりはコードが少し違いますが、

ベースとしては、

同じような記載になるかと思います。

TypeScriptでメソッドにする調整

先ほどの、

const axios = require('axios').default;

await Promise.all([

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

])

.then((response) => {

console.log(response);

})

.catch(function (response) {

console.log(response);

});こちらのコードをベースに、

syncのメソッドとして、

実行されるように調整します。

その調整したコードが、

async actionsStores(): void {

const axios = require('axios').default;

await Promise.all([

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

axios.get("url of api"),

])

.then((response) => {

console.log(response);

})

.catch(function (response) {

console.log(response);

});

}こちらです。

上記で調整したメソッドをベースに、

必要なaxiosの呼び出しは、

URLなどを変えるために、

ベットメソッドにしましたが、

そちらについては、

機会があれば、

追って追記予定。

XServer VPSでSSHキーを使って接続する方法

XServer VPSを試しに使い始めて、

SSH Keyでの接続について、

設定方法など、

備忘録としてメモしておきます。

XServer VPSの公式サイト

この記事で紹介するXServer VPSのサイトについては、

こちらのリンクから確認してみてください。

<div class="simple-page-link">

<a href="https://px.a8.net/svt/ejp?a8mat=3TB7JM+679KMQ+CO4+25EKCY" rel="nofollow">Xserver VPS</a>

<img border="0" width="1" height="1" src="https://www18.a8.net/0.gif?a8mat=3TB7JM+679KMQ+CO4+25EKCY" alt="">

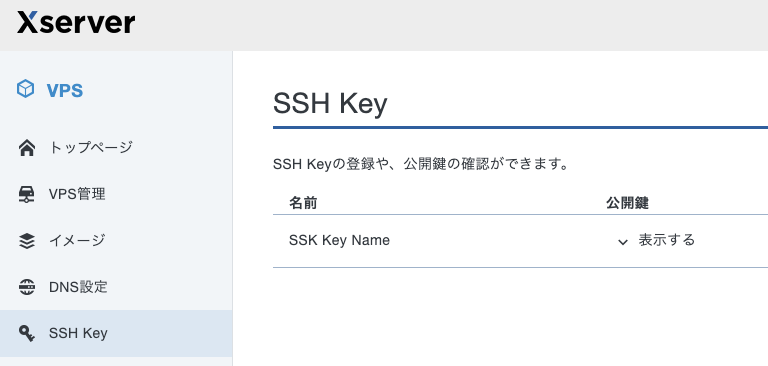

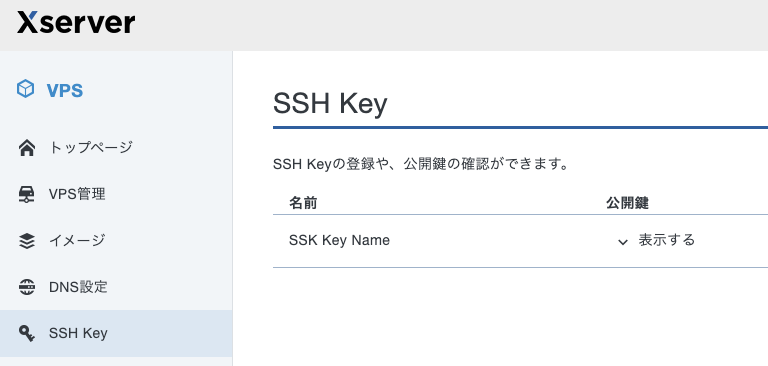

</div>XSever VPSのSSH Keyの作成

XServer VPSの管理画面に入って、

こちらの画面の中で、

「SSH Key」

のタイトルの右の方に、

こちらの

「SSH Keyの登録」

から、

新たなSSH Keyを追加できます。

名前の部分に、

作成するキーファイルの名前を設定。

登録方法は、

自動生成を使うと楽なので、

そちらで進めます。

「確認画面へ進む」

を選択すると、

こちらのように、

確認画面が表示されるので、

「登録する」

をクリックします。

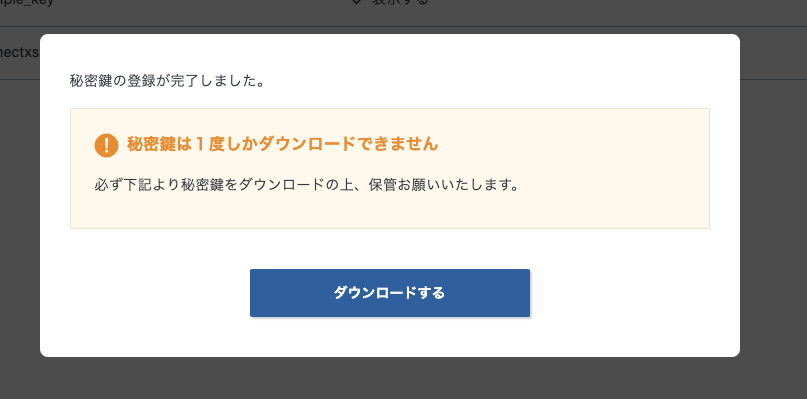

注意点としては、

この画面の後のダウンロードは必ず行って、

ファイルは無くさないようにしましょう。

注意ポイント:登録した後の以下のダウンロードのファイルは無くさないように注意です

上記のポイントの画面として、

先程の

「登録する」

の画面の次に、

こちらの画面が表示されるので、

「ダウンロードする」

からファイルをダウンロードしてください。

SSH Keyを使って接続するコマンド

先程の画面で、

ダウンロードしたファイルを使って、

XServer VPSに対して、

接続してみます。

実際の対応自体は、

自分の環境がMACですので、

その環境での対応方ですが、

Windowsでも行う流れは似たような対応になります。

まず、ファイル自体は、

sample_key.pemというファイル名でダウンロードしたので、

- 「.ssh」フォルダにSSH Keyファイルを配置

- ファイルの権限を「600」に変更

- sshコマンドでSSH Keyファイル指定で実行

という流れで、

対応を進めていきます。

まず、

- 「.ssh」フォルダにSSH Keyファイルを配置

こちらに関しては、

ファイルを上記の「.ssh」フォルダに配置して下さい。

そして、

- ファイルの権限を「600」に変更

を対応するので、

以下のコマンドで変更します。

コマンド

chmod 600 ~/.ssh/sample_key.pemこちらのコマンドで、

権限を変更が完了です。

最後に、

- sshコマンドでSSH Keyファイル指定で実行

で実際にXserver VPSへの接続を試します。

sshコマンドにオプション指定で、

実行することで接続できるので、

コマンド

ssh -i ~/.ssh/sample_key.pem root@VPSのIPアドレスで接続できます。

うまく接続できたら、

SSHで接続できるアカウントの変更や権限など、

セキュリティを調整していきましょう。

国内VPSでコスパを重視するなら「XServer VPS」がおすすめ

アプリケーションのサーバーを

クラウドで用意する際に、

AWSやGCPを使うことが多いです。

この点で、

従量課金の仕組みが心配などある方がいれば、

国内VPSを試してみるのも良いでしょう。

VPSに関しては、

- 国内VPS

- 利用料金がリーズナブル

- 管理画面の使い勝手が良い

- 安定性も高い

という点で、

「XServer VPS」

を使う機会があり、

おすすめできそうだと思ったので、

この記事で概要を共有します。

XServer VPSのサイトをチェック

まずは、

XServer VPSの公式サイトをチェック

XServer VPSとは

XServer VPSは、

海外運用が多いVPSの中で、

数少ない国産のVPSです。

個人的には、

VPNの中で、

- 国内VPS

- 利用料金がリーズナブル

- 管理画面の使い勝手が良い

- 安定性も高い

という点を考慮して、

おすすめできると判断しています。

コストパフォーマンスが高く、

安定性もしっかりしているので、

まずは、公式サイトでチェックしてみましょう。

Laravelのバージョンアップデートを試した時のメモ

Laravelを使用していて、

フレームワーク自体のバージョンの

アップデートを行おうとして、

その時に調整したことなど、

個人用にメモを残しておきます。

Laravelのバージョン

現在のバージョン確認

Laravelのバージョンとしては、

php artisan --versionというコマンドで確認すると、

$ php artisan --version

Laravel Framework 9.5.1というバージョンであることがわかります。

バージョンのアップデート

同一バージョンのアップデート

バージョンとして、

9.x系の最新にしたいので、

今のバージョンである

Laravel Framework 9.5.1から、

バージョンを9.x系での更新を行います。

コマンド

composer updateこのコマンドを実行すると、

アップデートが行われます。

終了したら、

バージョンがアップデートされていることを確認します。

php artisan --version$ php artisan --version

Laravel Framework 9.52.9うまくバージョンが変わっていますね。

こちらでバージョンのアップデートが完了です。

Laravel 9系から10系へのアップデート

先ほどのバージョンのアップデートは、

composer.jsonで指定されているバージョンの中で、

アップデートを行いました。

しかし、

大きなメジャーバージョンの変更についても、

行うことがあるので、

Laravel 9系から10系へのバージョンアップデートについて、

以下の対応でアップデートが可能です。

設定ファイルとして、

composer.jsonを変更します。

アップデートする際の設定情報については、

以下の公式サイトに記載があるので、

そちらを参考にしてください。

https://laravel.com/docs/10.x/upgrade#updating-dependencies

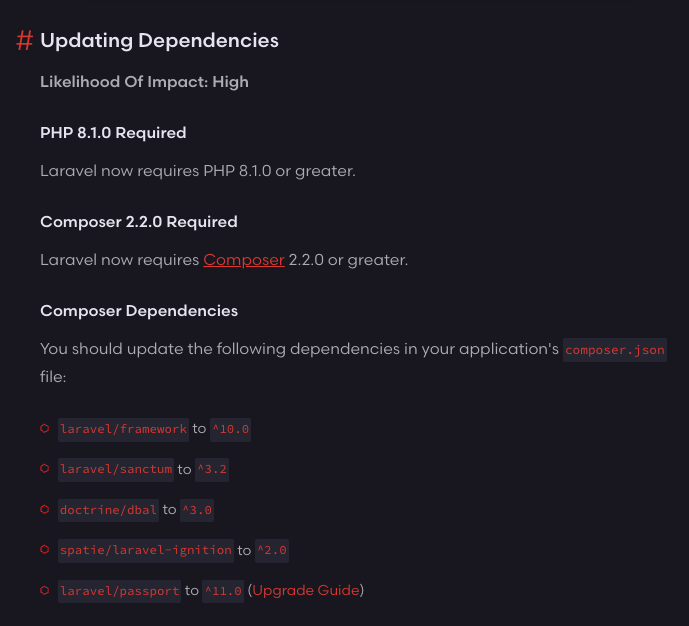

こちらの中で、

- 環境状況として必要な要件を満たす

- composer.jsonの指定バージョンを変更する

ということを行うことで、

バージョンアップデートが可能になります。

この辺りのバージョンの依存関係と呼ばれる環境や設定情報は、

「Updating Dependencies」

という部分に記載があり、

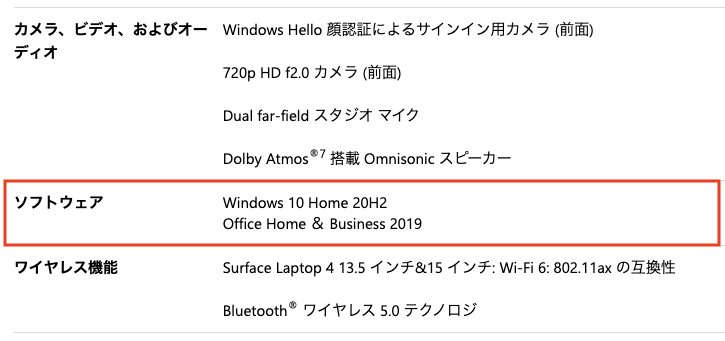

このような形で、

必要な環境や変更する設定などがありますので、

そちらを対応してください。

対応が完了したら、

composer updateのコマンドを実行することで、

バージョンアップデートが行われます。

実際にアップデートが完了したら、

php artisan --versionのコマンドで、

バージョン情報を確認してみると、

$ php artisan --version

Laravel Framework 10.13.5うまくバージョンが、

9系から10系へアップデートされています。

こちらのように、

フレームワークのバージョンアップデートを行ってください。

VPNを使うならノーログポリシーの国産VPN「MillenVPN」がおすすめ

フリーWifiを使うときや、

海外のサービスを活用するときなど、

有料のVPNを活用することで、

よりセキュアに使うことができます。

そんなVPNの中で、

- 国産VPN

- 利用料金がリーズナブル

- ノーログポリシー

- 海外から日本への接続も対応

という点で、

「Millen VPN」

を使う機会があり、

おすすめできそうだと思ったので、

この記事で概要を共有します。

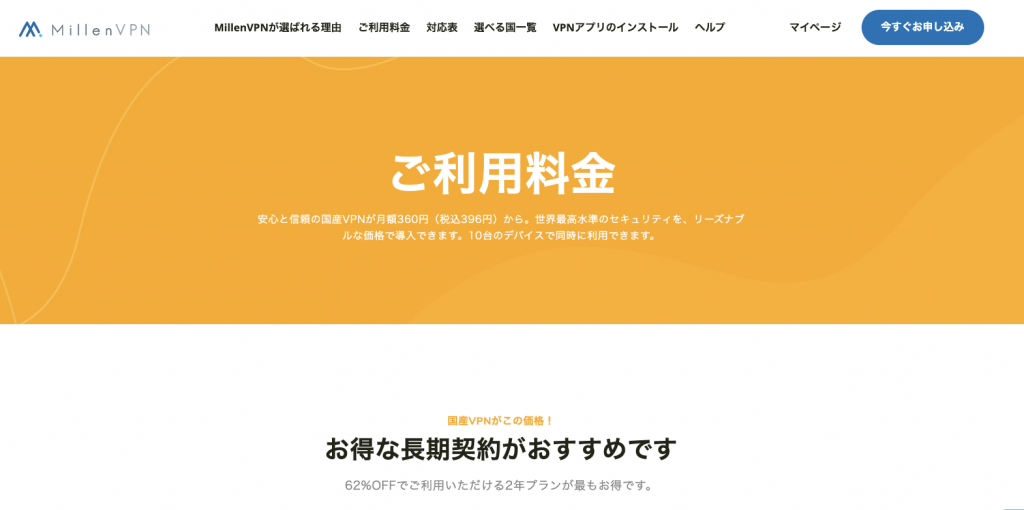

Millen VPNのサイトをチェック

まずは、

Millen VPNの公式サイトをチェック

Millen VPNとは

Millen VPNは、

海外運用が多いVPNの中で、

数少ない国産のVPNです。

個人的には、

VPNの中で、

- 国産VPN

- 利用料金がリーズナブル

- ノーログポリシー

- 海外から日本への接続も対応

という点を考慮して、

おすすめできると判断しています。

まず、

フリーWifiなどの安全な利用に関しては、

Millen VPNの方でもYoutubeに説明動画あるので、

以下を参考にしてください。

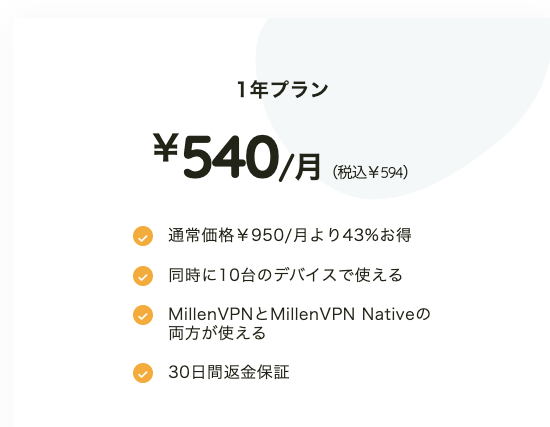

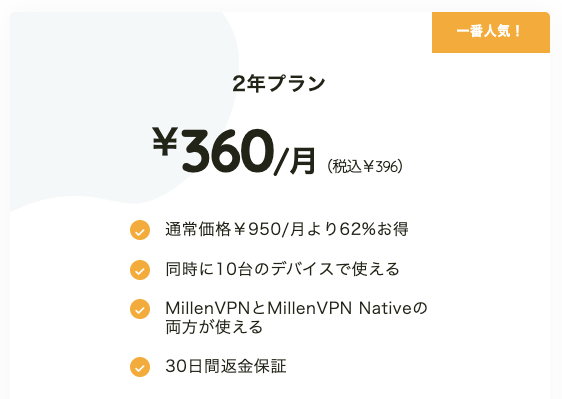

特徴(料金体系など)

特徴としては、

- 国産VPN

- 利用料金がリーズナブル

- ノーログポリシー

- 海外から日本への接続も対応

この4つが魅力的なポイントですね。

国産VPNであるという点に関しては、

- 不明点がある時に日本語で質問できる

という点が、

非常に助かるポイントです。

利用料金体系に関しても、

非常にリーズナブルな体系になっており、

1年間の利用であれば、

500円くらい、

2年間の使用であれば、

このように、

長期使用になるほど、

より割引されているので、

- 継続的に利用されるなら長期利用がおすすめ

と言えます。

また、

VPNを使用する上で、

セキュリティ担保として使用したいのが、

- ノーログポリシー

というセキュリティポリシーです。

公式サイトにも、

このようにしっかりと明記しているので、

安心して使用することができます。

さらに、

個人的に機能要件として、

サポートされている点として嬉しいのは、

- 海外から日本への接続も対応

という点です。

海外にあまり行かれない方は使う機会がないかもしれませんが、

海外から日本のサービスを活用する際に、

IPの問題でうまく使うことができないことがあります。

この点に関して、

Millen VPNでは、

このように、

他の海外運営のVPNとは違い、

国産VPNとして、

海外から日本に接続できる国の対応が、

他のVPNと比べてもしっかりしているので、

この点でも非常におすすめです。

短い期間でも、

試すことができるので、

まずは、公式サイトでチェックしてみましょう。

composerのバージョンを変更する方法

composerを使用していて、

各種ああ

バージョン情報

現時点のcomposerのバージョン確認

composer -V確認結果

$ composer -V

/ ____/___ ____ ___ ____ ____ ________ _____

/ / / __ \/ __ `__ \/ __ \/ __ \/ ___/ _ \/ ___/

/ /___/ /_/ / / / / / / /_/ / /_/ (__ ) __/ /

\____/\____/_/ /_/ /_/ .___/\____/____/\___/_/

/_/

Composer version 2.1.14バージョンの変更

composerのバージョンを指定バージョンに変更します。

変更するコマンドは以下。

変更コマンド

コマンド

composer self-update 2.5.8実行結果

$ composer self-update 2.5.8

Upgrading to version 2.5.8 (stable channel).

Use composer self-update --rollback to return to version 2.1.14実行結果確認

実際に変更されたのか、

バージョンを確認してみる。

確認コマンド

composer -v確認結果

$ composer -v

______

/ ____/___ ____ ___ ____ ____ ________ _____

/ / / __ \/ __ `__ \/ __ \/ __ \/ ___/ _ \/ ___/

/ /___/ /_/ / / / / / / /_/ / /_/ (__ ) __/ /

\____/\____/_/ /_/ /_/ .___/\____/____/\___/_/

/_/

Composer version 2.5.8これでうまくバージョンの変更が完了しました。

Next.jsで別ドメインの画像ファイルを表示させる方法

Nextjsで実装していたときに、

画像の表示において、

- 別ドメインの画像URLを表示させる

ということを、

構築しているシステムで試そうとした。

画像管理はバックエンドのシステムの方で行うので、

それを表示させたいという点で、

ドメインをサブドメインで切り分けていたので、

その点でうまく表示されない事象が起きた。

今回は、

上記で行いたかったことに関して、

試したことや起きた事象など、

備忘録としてこの記事に残します。

公式サイトの情報

公式サイトで、

Next.jsに関する情報は確認。

画像表示の基本

画像表示については、

<Image>のタグを使って、

import Image from 'next/image';

export default function Page() {

return (

<Image

src="/profile.png"

width={500}

height={500}

alt="Picture of the author"

/>

);

}という形で、

画像表示を行いました。

こちらの画像表示については、

以下の公式サイトも確認。

別ドメインの画像表示を試すとエラー

上記の画像表示を使用して、

別ドメインで試したところ、

Unhandled Runtime Error

Error: Invalid src prop (https://sample.com/xxxxx.png) on `next/image`,

hostname "sample.com" is not configured under images in your `next.config.js`

See more info: https://nextjs.org/docs/messages/next-image-unconfigured-host上記のエラーが発生した。

エラー内容の中に、

以下を確認するように記載があるので、

こちらも確認してもらうと良いですね。

https://nextjs.org/docs/messages/next-image-unconfigured-host

別ドメインの画像表示のための設定

上記の別ドメインの画像表示のエラーの対応方法として、

next.jsの設定ファイルに対して、

ドメインを設定する必要があります。

調整ファイル

next.config.js調整内容

const nextConfig = {

images: {

domains: ['sample.com'],

},

}このように、

設定ファイルの中に、

画像用のドメインを設定する必要があります。

こちらを調整した後に、

再コンパイルすると、

うまく別ドメインの画像が表示されました。

Next.jsで環境設定値を表示側でも使う方法

Nextjsで実装していたときに、

環境設定値を試したときに、

表示側に環境設定値を使おうとして、

その時に試したことや、

公式サイトで確認したことなどをメモ。

事前に環境設定値を使う方法は、

Next.js でprocess.envで環境値を設定して使う方法

こちらの記事でも試していたので、

そちらも参考にしてもらえると良いですね。

今回は、上記に加えて、

やりたかったことやうまくいかなかったことを、

備忘録としてこの記事に残します。

公式サイトの情報

公式サイトの中で、

環境設定値に関して、

記載されている部分は、

以下のリンク先にあります。

環境設定値を表示側でも使いたい

やりたかったこととしては、

表示側で、

export default function SampleView() {

return (

<>

サンプル表示値

</>

)

}という表示部分で、

サンプル表示値などの値を、

環境設定値として持たせて、

表示させようとしました。

環境設定値でうまくいかないパターン

環境設定値として、

.envの環境ファイルに、

SAMPLE_VALUE=サンプル表示値という設定を行って、

export default function SampleView() {

return (

<>

{process.env.SAMPLE_VALUE}

</>

)

}で表示させようとしたが、

うまく表示されなかった。

環境設定値を表示側でうまくいく方法

上記で使おうとしていた、

.envの環境ファイルに、

SAMPLE_VALUE=サンプル表示値この値を使うには、

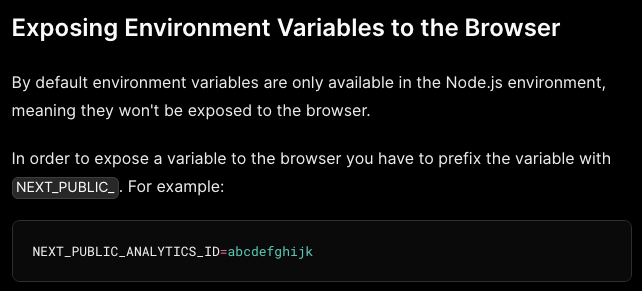

の中の以下の部分が重要でした。

上記の記載の中で、

In order to expose a variable to the browser

you have to prefix the variable with NEXT_PUBLIC_.

For example:

NEXT_PUBLIC_ANALYTICS_ID=abcdefghijkということが書かれており、

NEXT_PUBLIC_というものを、

プレフィックスとして使う必要があります。

例として、

NEXT_PUBLIC_ANALYTICS_ID=abcdefghijkということがあるので、

こちらを参考に試してみます。

環境ファイル

.env設定値

NEXT_PUBLIC_SAMPLE_VALUE=サンプル表示値表示側での環境設定値の使用

export default function SampleView() {

return (

<>

{process.env.NEXT_PUBLIC_SAMPLE_VALUE}

</>

)

}上記で試すと、

うまく環境設定値を取得して、

画面にも表示できました。

NginxでHttpをHttpsにリダイレクトさせる設定方法

Nginxで各種ドメインを設定して、

Webサーバーを管理していく中で、

SSL証明書を設定しようとしたときに、

無料のLet’s Encryptから証明書を取得してから、

- HTTPをHTTPSにリダイレクトさせる

ということを行おうとして、

Nginxの設定ファイルを調整した時のメモを

備忘録として、個人用に残しておきます。

前提:Ubuntuを使用

前提としては、

環境としてUbuntuを使用しています。

ファイルパスなどを、

必要な環境パスに変えてもらえれば、

Nginxの中の設定は同じ形でいけると思います。

Nginxの設定ファイル

Nginxの設定ファイルは、

設定ファイルの場所

/etc/nginx/conf.d設定ファイル

個別ファイル.confNginxのHTTPとHTTPSのリダイレクトの設定

上記のファイルの中で、

リダイレクトの設定を追加します。

server {

listen 80;

server_name example.com;

return 301 https://$host$request_uri;

}

server {

listen 443 ssl;

:

}上記の設定を行って、

Nginxの再起動を行います。

再起動コマンド

nginx -s reload上記のコマンドで再起動を行ってから、

実際に表示確認をすると、

HTTPからHTTPSにリダイレクトがうまくいきました。

NuxtでSiteMapを生成する方法

Vueを活用する中で、

「Nuxt」

のフレームワークを使用して、

既存で作っていたものを、

試しにリプレイスしようとしている。

そんな中で、

- SiteMap

を生成しようとした時に、

調べたことなどを、

個人用にメモ。

ちなみに、

Nuxtのバージョンについても、

バージョン2系ではなく、

バージョン3系を導入して、

Nuxtを試している。

個人用の備忘録としてメモを残しておく。

Nuxt.jsの公式サイト

Nuxt.jsに関しては、

こちらのサイトを参考にしました。

リンクをメモ。

NuxtのModulesを確認

NuxtのModulesを確認すると、

- simple-sitemap

というモジュールがあるようなので、

こちらを使ってみます。

simple-sitemapを試す

上記の公式サイトにも記載のある、

simple-sitemap

を試します。

コマンド

npm i nuxt-simple-sitemapこちらで、

モジュールのインストールを実施。

次に設定を行います。

最新情報は、

上記のNPMパッケージのサイトから、

Githubページを見てもらえると良いですね。

実際に試した時のメモ。

修正ファイル

nuxt.config.ts調整内容

export default defineNuxtConfig({

modules: [

'nuxt-simple-sitemap',

],

runtimeConfig: {

public: {

siteUrl: process.env.NUXT_PUBLIC_SITE_URL || 'https://example.com',

}

},

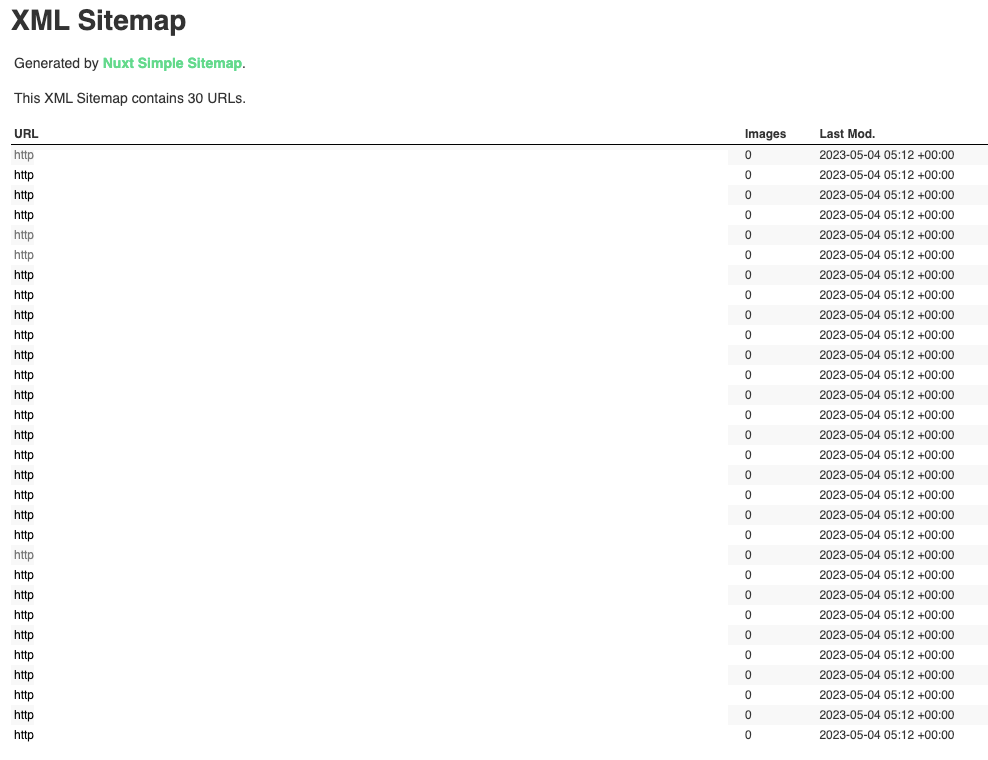

})上記の調整を行って、

実際にコンパイル等を行って、

https://example.com/sitemap.xmlを確認してみると、

このような感じで、

sitemapが作成されました。

URL指定でファイル取得するwgetで保存フォルダ先を指定する方法

Ubuntuの中で、

ファイル取得の方法として、

- wget

を使用して、

ファイル取得を行おうとした際に、

保存先のフォルダを指定して、

動作させたいと考え、

その際に、

wgetのオプションの一部を確認して、

実際に試した時のことを、

この記事にメモとして残しておきます。

wgetのコマンド

今回、実行するコマンドが、

wgetというコマンドで、

オプション指定なしでも使うことができます。

例えば、

wget https://example.com/img/sample.pngという形で、

オプションなしで実行することができます。

取得先のフォルダを指定する

取得先のフォルダを指定して、

wgetでのファイル取得のアクションを実行します。

オプション情報の確認は、

以下のコマンドで確認できます。

コマンド

wget --help確認結果(一部抜粋)

$ wget --help

:

:

Directories:

-nd, --no-directories don't create directories

-x, --force-directories force creation of directories

-nH, --no-host-directories don't create host directories

--protocol-directories use protocol name in directories

-P, --directory-prefix=PREFIX save files to PREFIX/..

:

:という形で、

オプション情報が表示されるので、

必要なオプションを確認して実行します。

今回、実行したい方法として、

- 保存先のフォルダを指定する

を実施したかったので、

-P, --directory-prefix=PREFIX save files to PREFIX/..のオプションを指定して、

wgetコマンドを実行します。

具体的には、

wget -P /target_folder https://example.com/get_file.pngという形で、

オプションをつけたコマンドを実行します。

こちらを実行すると、

$ wget -P /target_folder https://example.com/get_file.png

HTTP request sent, awaiting response... 200

Length: 55469 (54K) [image/png]

Saving to: ‘/target_folder/get_file.png’

get_file.png 100%[===================>] 54.17K --.-KB/s in 0.1s

2023-05-06 20:29:57 (401 KB/s)

‘/target_folder/get_file.png’ saved [55469/55469]このように、

うまく実行され、

wgetコマンドで指定フォルダに対して、

ファイルが取得されていますね。

NuxtのuseStateでの値保持で値が初期化されてしまう事象に関するメモ

Vueを活用する中で、

「Nuxt」

のフレームワークを使用して、

既存で作っていたものを、

試しにリプレイスしようとしている。

そんな中で、

- useState

を使って、

状態管理を実現しようとしているが、

ページ遷移部分で、

1度、設定した値が、

再度、初期化されてしまう事象があり、

うまくいく場合と、

うまくいかない場合を確認したところ、

対応方法によって挙動が違ったのでメモ。

ちなみに、

Nuxtのバージョンについても、

バージョン2系ではなく、

バージョン3系を導入して、

Nuxtを試している。

個人用の備忘録としてメモを残しておく。

Nuxt.jsの公式サイト

Nuxt.jsに関しては、

こちらのサイトを参考にしました。

リンクをメモ。

useStateを試した時のメモ

上記の公式サイトのuseStateのコードを参考に、

useStateを活用するコードを書いていきます。

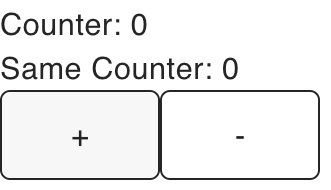

useStateの設定と取得

<script setup>

const counter = useState('counter', () => 0);

const sameCounter = useState('counter');

</script>画面への表示

<div>

<div>Counter: {{ counter }}</div>

<div>Same Counter: {{ sameCounter }}</div>

<button class="font-mono" @click="counter++">

+

</button>

<button class="font-mono" @click="counter--">

-

</button>

</div>上記を試すと、

このように、

ボタン押下で、

うまく値が変わっていることがわかります。

うまくいかない事象が発生

上記をベースに、

app.vueだけではなく、

/pagesなどのページや、

/componentsなどのコンポーネントの中で、

同じことを試していましたが、

基本的には、

問題なく動いていました。

うまくいかない事象が発生したのは、

ページ遷移を行った際に、

値がうまく保持できず、

このように値が初期化されてしまっていました。

ページ遷移の方法をNuxtのLinkにすることで解決

上記で、

ページ遷移時に値が初期化されてしまう事象ですが、

うまく値が保持されている部分と、

値が初期化されてしまう事象が発生している部分を、

それぞれ、

細かく確認していったところ、

- wondow.locationでは値が初期化される

というところが問題でした。

ページ描画の部分で、

この点を解決するために、

イベント発火を拾って、

window.location = '遷移先画面URL';としていたところを、

イベント発火させている項目自体を、

<NuxtLink :to="child.page">{{ child.text }}</NuxtLink>というように、

NuxtLinkを使って、

画面遷移することで、

値の保持がうまく挙動しました。

NuxtでuseHeadで.envの環境変数を扱う方法

Vueを活用する中で、

「Nuxt」

のフレームワークを使用して、

既存で作っていたものを、

試しにリプレイスしようとしている。

そんな中で、

- useHead

を使って、

<meta name="description" content="メタ情報">このような、

メタ情報を表示をするために、

設定を試した。

その時のメモは、

以下を参照してほしい。

こちらを対応した上で、

一部の値を環境変数として、

- .env

のファイルに、

値を持たせたかったので、

その方法を試した。

ちなみに、

Nuxtのバージョンについても、

バージョン2系ではなく、

バージョン3系を導入して、

Nuxtを試している。

個人用の備忘録としてメモを残しておく。

Nuxt.jsの公式サイト

Nuxt.jsに関しては、

こちらのサイトを参考にしました。

リンクをメモ。

useHeadを試した時のメモ

Nuxtの設定の中で、

useHeadについては、

SEO and Meta

のページに記載されています。

こちらに関しては、

公式サイトの情報と、

試した時のメモの記事を載せておきます。

.envの環境変数の値を使う

上記の対応に加えて、

実際の設定したい値の一部を、

.envの環境変数に値を持たせることを試します。

公式情報としては、

こちらを参考にしてください。

https://nuxt.com/docs/guide/going-further/runtime-config

上記をもとに、

試していきます。

環境変数のファイルとして、

.envのファイルに、

SAMPLE="sample value"このように、

環境変数として値を設定します。

こちらを、

nuxt.config.tsに設定を追加します。

上記の公式サイトで、

export default defineNuxtConfig({

runtimeConfig: {

// The private keys which are only available within server-side

apiSecret: '123',

// Keys within public, will be also exposed to the client-side

public: {

apiBase: '/api'

}

}

})

こちらについて、

When adding apiBase to the runtimeConfig.public,

Nuxt adds it to each page payload.

We can universally access apiBase in both server and browser.

と丁寧に書かれており、

値のアクセスに関しても、

const runtimeConfig = useRuntimeConfig()

console.log(runtimeConfig.apiSecret)

console.log(runtimeConfig.public.apiBase)

という形でアクセスができると記載があります。

こちらを組み合わせて試すと、

export default defineNuxtConfig({

runtimeConfig: {

// The private keys which are only available within server-side

apiSecret: '123',